RocketMQ

基本介绍

消息队列

应用场景

消息队列是一种先进先出的数据结构,常见的应用场景:

-

应用解耦:系统的耦合性越高,容错性就越低

实例:用户创建订单后,耦合调用库存系统、物流系统、支付系统,任何一个子系统出了故障都会造成下单异常,影响用户使用体验。使用消息队列解耦合,比如物流系统发生故障,需要几分钟恢复,将物流系统要处理的数据缓存到消息队列中,用户的下单操作正常完成。等待物流系统正常后处理存在消息队列中的订单消息即可,终端系统感知不到物流系统发生过几分钟故障

-

流量削峰:应用系统如果遇到系统请求流量的瞬间猛增,有可能会将系统压垮,使用消息队列可以将大量请求缓存起来,分散到很长一段时间处理,这样可以提高系统的稳定性和用户体验

-

数据分发:让数据在多个系统更加之间进行流通,数据的产生方不需要关心谁来使用数据,只需要将数据发送到消息队列,数据使用方直接在消息队列中直接获取数据

参考视频:https://www.bilibili.com/video/BV1L4411y7mn

技术选型

RocketMQ 对比 Kafka 的优点

- 支持 Pull和 Push 两种消息模式

- 支持延时消息、死信队列、消息重试、消息回溯、消息跟踪、事务消息等高级特性

- 对消息可靠性做了改进,保证消息不丢失并且至少消费一次,与 Kafka 一样是先写 PageCache 再落盘,并且数据有多副本

- RocketMQ 存储模型是所有的 Topic 都写到同一个 Commitlog 里,是一个 append only 操作,在海量 Topic 下也能将磁盘的性能发挥到极致,并且保持稳定的写入时延。Kafka 的吞吐非常高(零拷贝、操作系统页缓存、磁盘顺序写),但是在多 Topic 下时延不够稳定(顺序写入特性会被破坏从而引入大量的随机 I/O),不适合实时在线业务场景

- 经过阿里巴巴多年双 11 验证过、可以支持亿级并发的开源消息队列

Kafka 比 RocketMQ 吞吐量高:

-

Kafka 将 Producer 端将多个小消息合并,采用异步批量发送的机制,当发送一条消息时,消息并没有发送到 Broker 而是缓存起来,直接向业务返回成功,当缓存的消息达到一定数量时再批量发送

-

减少了网络 I/O,提高了消息发送的性能,但是如果消息发送者宕机,会导致消息丢失,降低了可靠性

-

RocketMQ 缓存过多消息会导致频繁 GC,并且为了保证可靠性没有采用这种方式

Topic 的 partition 数量过多时,Kafka 的性能不如 RocketMQ:

-

两者都使用文件存储,但是 Kafka 是一个分区一个文件,Topic 过多时分区的总量也会增加,过多的文件导致对消息刷盘时出现文件竞争磁盘,造成性能的下降。一个分区只能被一个消费组中的一个消费线程进行消费,因此可以同时消费的消费端也比较少

-

RocketMQ 所有队列都存储在一个文件中,每个队列存储的消息量也比较小,因此多 Topic 的对 RocketMQ 的性能的影响较小

安装测试

安装需要 Java 环境,下载解压后进入安装目录,进行启动:

-

启动 NameServer

# 1.启动 NameServer nohup sh bin/mqnamesrv & # 2.查看启动日志 tail -f ~/logs/rocketmqlogs/namesrv.logRocketMQ 默认的虚拟机内存较大,需要编辑如下两个配置文件,修改 JVM 内存大小

# 编辑runbroker.sh和runserver.sh修改默认JVM大小 vi runbroker.sh vi runserver.sh参考配置:JAVA_OPT=“${JAVA_OPT} -server -Xms256m -Xmx256m -Xmn128m -XX:MetaspaceSize=128m -XX:MaxMetaspaceSize=320m”

-

启动 Broker

# 1.启动 Broker nohup sh bin/mqbroker -n localhost:9876 autoCreateTopicEnable=true & # 2.查看启动日志 tail -f ~/logs/rocketmqlogs/broker.log -

发送消息:

# 1.设置环境变量 export NAMESRV_ADDR=localhost:9876 # 2.使用安装包的 Demo 发送消息 sh bin/tools.sh org.apache.rocketmq.example.quickstart.Producer -

接受消息:

# 1.设置环境变量 export NAMESRV_ADDR=localhost:9876 # 2.接收消息 sh bin/tools.sh org.apache.rocketmq.example.quickstart.Consumer -

关闭 RocketMQ:

# 1.关闭 NameServer sh bin/mqshutdown namesrv # 2.关闭 Broker sh bin/mqshutdown broker

相关概念

RocketMQ 主要由 Producer、Broker、Consumer 三部分组成,其中 Producer 负责生产消息,Consumer 负责消费消息,Broker 负责存储消息,NameServer 负责管理 Broker

- 代理服务器(Broker Server):消息中转角色,负责存储消息、转发消息。在 RocketMQ 系统中负责接收从生产者发送来的消息并存储、同时为消费者的拉取请求作准备,也存储消息相关的元数据,包括消费者组、消费进度偏移和主题和队列消息等

- 名字服务(Name Server):充当路由消息的提供者。生产者或消费者能够通过名字服务查找各主题相应的 Broker IP 列表

- 消息生产者(Producer):负责生产消息,把业务应用系统里产生的消息发送到 Broker 服务器。RocketMQ 提供多种发送方式,同步发送、异步发送、顺序发送、单向发送,同步和异步方式均需要 Broker 返回确认信息,单向发送不需要;可以通过 MQ 的负载均衡模块选择相应的 Broker 集群队列进行消息投递,投递的过程支持快速失败并且低延迟

- 消息消费者(Consumer):负责消费消息,一般是后台系统负责异步消费,一个消息消费者会从 Broker 服务器拉取消息、并将其提供给应用程序。从用户应用的角度而提供了两种消费形式:

- 拉取式消费(Pull Consumer):应用通主动调用 Consumer 的拉消息方法从 Broker 服务器拉消息,主动权由应用控制,一旦获取了批量消息,应用就会启动消费过程

- 推动式消费(Push Consumer):该模式下 Broker 收到数据后会主动推送给消费端,实时性较高

- 生产者组(Producer Group):同一类 Producer 的集合,发送同一类消息且发送逻辑一致。如果发送的是事务消息且原始生产者在发送之后崩溃,则 Broker 服务器会联系同一生产者组的其他生产者实例以提交或回溯消费

- 消费者组(Consumer Group):同一类 Consumer 的集合,消费者实例必须订阅完全相同的 Topic,消费同一类消息且消费逻辑一致。消费者组使得在消息消费方面更容易的实现负载均衡和容错。RocketMQ 支持两种消息模式:

- 集群消费(Clustering):相同 Consumer Group 的每个 Consumer 实例平均分摊消息

- 广播消费(Broadcasting):相同 Consumer Group 的每个 Consumer 实例都接收全量的消息

每个 Broker 可以存储多个 Topic 的消息,每个 Topic 的消息也可以分片存储于不同的 Broker,Message Queue(消息队列)是用于存储消息的物理地址,每个 Topic 中的消息地址存储于多个 Message Queue 中

-

主题(Topic):表示一类消息的集合,每个主题包含若干条消息,每条消息只属于一个主题,是 RocketMQ 消息订阅的基本单位

-

消息(Message):消息系统所传输信息的物理载体,生产和消费数据的最小单位,每条消息必须属于一个主题。RocketMQ 中每个消息拥有唯一的 Message ID,且可以携带具有业务标识的 Key,系统提供了通过 Message ID 和 Key 查询消息的功能

-

标签(Tag):为消息设置的标志,用于同一主题下区分不同类型的消息。标签能够有效地保持代码的清晰度和连贯性,并优化 RocketMQ 提供的查询系统,消费者可以根据 Tag 实现对不同子主题的不同消费逻辑,实现更好的扩展性

-

普通顺序消息(Normal Ordered Message):消费者通过同一个消息队列(Topic 分区)收到的消息是有顺序的,不同消息队列收到的消息则可能是无顺序的

-

严格顺序消息(Strictly Ordered Message):消费者收到的所有消息均是有顺序的

官方文档:https://github.com/apache/rocketmq/tree/master/docs/cn(基础知识部分的笔记参考官方文档编写)

消息操作

基本样例

订阅发布

消息的发布是指某个生产者向某个 Topic 发送消息,消息的订阅是指某个消费者关注了某个 Topic 中带有某些 Tag 的消息,进而从该 Topic 消费数据

导入 MQ 客户端依赖:

<dependency>

<groupId>org.apache.rocketmq</groupId>

<artifactId>rocketmq-client</artifactId>

<version>4.4.0</version>

</dependency>

消息发送者步骤分析:

- 创建消息生产者 Producer,并制定生产者组名

- 指定 Nameserver 地址

- 启动 Producer

- 创建消息对象,指定主题 Topic、Tag 和消息体

- 发送消息

- 关闭生产者 Producer

消息消费者步骤分析:

- 创建消费者 Consumer,制定消费者组名

- 指定 Nameserver 地址

- 订阅主题 Topic 和 Tag

- 设置回调函数,处理消息

- 启动消费者 Consumer

官方文档:https://github.com/apache/rocketmq/blob/master/docs/cn/RocketMQ_Example.md

发送消息

同步发送

使用 RocketMQ 发送三种类型的消息:同步消息、异步消息和单向消息,其中前两种消息是可靠的,因为会有发送是否成功的应答

这种可靠性同步地发送方式使用的比较广泛,比如:重要的消息通知,短信通知

public class SyncProducer {

public static void main(String[] args) throws Exception {

// 实例化消息生产者Producer

DefaultMQProducer producer = new DefaultMQProducer("please_rename_unique_group_name");

// 设置NameServer的地址

producer.setNamesrvAddr("localhost:9876");

// 启动Producer实例

producer.start();

for (int i = 0; i < 100; i++) {

// 创建消息,并指定Topic,Tag和消息体

Message msg = new Message(

"TopicTest" /* Topic */,

"TagA" /* Tag */,

("Hello RocketMQ " + i).getBytes(RemotingHelper.DEFAULT_CHARSET) /* Message body */);

// 发送消息到一个Broker

SendResult sendResult = producer.send(msg);

// 通过sendResult返回消息是否成功送达

System.out.printf("%s%n", sendResult);

}

// 如果不再发送消息,关闭Producer实例。

producer.shutdown();

}

}

异步发送

异步消息通常用在对响应时间敏感的业务场景,即发送端不能容忍长时间地等待 Broker 的响应

public class AsyncProducer {

public static void main(String[] args) throws Exception {

// 实例化消息生产者Producer

DefaultMQProducer producer = new DefaultMQProducer("please_rename_unique_group_name");

// 设置NameServer的地址

producer.setNamesrvAddr("localhost:9876");

// 启动Producer实例

producer.start();

producer.setRetryTimesWhenSendAsyncFailed(0);

int messageCount = 100;

// 根据消息数量实例化倒计时计算器

final CountDownLatch2 countDownLatch = new CountDownLatch2(messageCount);

for (int i = 0; i < messageCount; i++) {

final int index = i;

// 创建消息,并指定Topic,Tag和消息体

Message msg = new Message("TopicTest", "TagA", "OrderID188",

"Hello world".getBytes(RemotingHelper.DEFAULT_CHARSET));

// SendCallback接收异步返回结果的回调

producer.send(msg, new SendCallback() {

// 发送成功回调函数

@Override

public void onSuccess(SendResult sendResult) {

countDownLatch.countDown();

System.out.printf("%-10d OK %s %n", index, sendResult.getMsgId());

}

@Override

public void onException(Throwable e) {

countDownLatch.countDown();

System.out.printf("%-10d Exception %s %n", index, e);

e.printStackTrace();

}

});

}

// 等待5s

countDownLatch.await(5, TimeUnit.SECONDS);

// 如果不再发送消息,关闭Producer实例。

producer.shutdown();

}

}

单向发送

单向发送主要用在不特别关心发送结果的场景,例如日志发送

public class OnewayProducer {

public static void main(String[] args) throws Exception{

// 实例化消息生产者Producer

DefaultMQProducer producer = new DefaultMQProducer("please_rename_unique_group_name");

// 设置NameServer的地址

producer.setNamesrvAddr("localhost:9876");

// 启动Producer实例

producer.start();

for (int i = 0; i < 100; i++) {

// 创建消息,并指定Topic,Tag和消息体

Message msg = new Message("TopicTest","TagA",

("Hello RocketMQ " + i).getBytes(RemotingHelper.DEFAULT_CHARSET));

// 发送单向消息,没有任何返回结果

producer.sendOneway(msg);

}

// 如果不再发送消息,关闭Producer实例。

producer.shutdown();

}

}

消费消息

public class Consumer {

public static void main(String[] args) throws InterruptedException, MQClientException {

// 实例化消费者

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("please_rename_unique_group_name");

// 设置NameServer的地址

consumer.setNamesrvAddr("localhost:9876");

// 订阅一个或者多个Topic,以及Tag来过滤需要消费的消息

consumer.subscribe("TopicTest", "*");

// 注册消息监听器,回调实现类来处理从broker拉取回来的消息

consumer.registerMessageListener(new MessageListenerConcurrently() {

// 接受消息内容

@Override

public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs, ConsumeConcurrentlyContext context) {

System.out.printf("%s Receive New Messages: %s %n", Thread.currentThread().getName(), msgs);

// 标记该消息已经被成功消费

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

// 启动消费者实例

consumer.start();

System.out.printf("Consumer Started.%n");

}

}

顺序消息

原理解析

消息有序指的是一类消息消费时,能按照发送的顺序来消费。例如:一个订单产生了三条消息分别是订单创建、订单付款、订单完成。消费时要按照这个顺序消费才能有意义,但是同时订单之间是可以并行消费的,RocketMQ 可以严格的保证消息有序。

顺序消息分为全局顺序消息与分区顺序消息,

- 全局顺序:对于指定的一个 Topic,所有消息按照严格的先入先出(FIFO)的顺序进行发布和消费,适用于性能要求不高,所有的消息严格按照 FIFO 原则进行消息发布和消费的场景

- 分区顺序:对于指定的一个 Topic,所有消息根据 Sharding key 进行分区,同一个分组内的消息按照严格的 FIFO 顺序进行发布和消费。Sharding key 是顺序消息中用来区分不同分区的关键字段,和普通消息的 Key 是完全不同的概念,适用于性能要求高的场景

在默认的情况下消息发送会采取 Round Robin 轮询方式把消息发送到不同的 queue(分区队列),而消费消息是从多个 queue 上拉取消息,这种情况发送和消费是不能保证顺序。但是如果控制发送的顺序消息只依次发送到同一个 queue 中,消费的时候只从这个 queue 上依次拉取,则就保证了顺序。当发送和消费参与的 queue 只有一个,则是全局有序;如果多个queue 参与,则为分区有序,即相对每个 queue,消息都是有序的

代码实现

一个订单的顺序流程是:创建、付款、推送、完成,订单号相同的消息会被先后发送到同一个队列中,消费时同一个 OrderId 获取到的肯定是同一个队列

public class Producer {

public static void main(String[] args) throws Exception {

DefaultMQProducer producer = new DefaultMQProducer("please_rename_unique_group_name");

producer.setNamesrvAddr("127.0.0.1:9876");

producer.start();

// 标签集合

String[] tags = new String[]{"TagA", "TagC", "TagD"};

// 订单列表

List<OrderStep> orderList = new Producer().buildOrders();

Date date = new Date();

SimpleDateFormat sdf = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

String dateStr = sdf.format(date);

for (int i = 0; i < 10; i++) {

// 加个时间前缀

String body = dateStr + " Hello RocketMQ " + orderList.get(i);

Message msg = new Message("OrderTopic", tags[i % tags.length], "KEY" + i, body.getBytes());

/**

* 参数一:消息对象

* 参数二:消息队列的选择器

* 参数三:选择队列的业务标识(订单 ID)

*/

SendResult sendResult = producer.send(msg, new MessageQueueSelector() {

@Override

/**

* mqs:队列集合

* msg:消息对象

* arg:业务标识的参数

*/

public MessageQueue select(List<MessageQueue> mqs, Message msg, Object arg) {

Long id = (Long) arg;

long index = id % mqs.size(); // 根据订单id选择发送queue

return mqs.get((int) index);

}

}, orderList.get(i).getOrderId());//订单id

System.out.println(String.format("SendResult status:%s, queueId:%d, body:%s",

sendResult.getSendStatus(),

sendResult.getMessageQueue().getQueueId(),

body));

}

producer.shutdown();

}

// 订单的步骤

private static class OrderStep {

private long orderId;

private String desc;

// set + get

}

// 生成模拟订单数据

private List<OrderStep> buildOrders() {

List<OrderStep> orderList = new ArrayList<OrderStep>();

OrderStep orderDemo = new OrderStep();

orderDemo.setOrderId(15103111039L);

orderDemo.setDesc("创建");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111065L);

orderDemo.setDesc("创建");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111039L);

orderDemo.setDesc("付款");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103117235L);

orderDemo.setDesc("创建");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111065L);

orderDemo.setDesc("付款");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103117235L);

orderDemo.setDesc("付款");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111065L);

orderDemo.setDesc("完成");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111039L);

orderDemo.setDesc("推送");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103117235L);

orderDemo.setDesc("完成");

orderList.add(orderDemo);

orderDemo = new OrderStep();

orderDemo.setOrderId(15103111039L);

orderDemo.setDesc("完成");

orderList.add(orderDemo);

return orderList;

}

}

// 顺序消息消费,带事务方式(应用可控制Offset什么时候提交)

public class ConsumerInOrder {

public static void main(String[] args) throws Exception {

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("please_rename_unique_group_name_3");

consumer.setNamesrvAddr("127.0.0.1:9876");

// 设置Consumer第一次启动是从队列头部开始消费还是队列尾部开始消费

// 如果非第一次启动,那么按照上次消费的位置继续消费

consumer.setConsumeFromWhere(ConsumeFromWhere.CONSUME_FROM_FIRST_OFFSET);

// 订阅三个tag

consumer.subscribe("OrderTopic", "TagA || TagC || TagD");

consumer.registerMessageListener(new MessageListenerOrderly() {

Random random = new Random();

@Override

public ConsumeOrderlyStatus consumeMessage(List<MessageExt> msgs, ConsumeOrderlyContext context) {

context.setAutoCommit(true);

for (MessageExt msg : msgs) {

// 可以看到每个queue有唯一的consume线程来消费, 订单对每个queue(分区)有序

System.out.println("consumeThread=" + Thread.currentThread().getName() + "queueId=" + msg.getQueueId() + ", content:" + new String(msg.getBody()));

}

return ConsumeOrderlyStatus.SUCCESS;

}

});

consumer.start();

System.out.println("Consumer Started.");

}

}

延时消息

原理解析

定时消息(延迟队列)是指消息发送到 Broker 后,不会立即被消费,等待特定时间投递给真正的 Topic

RocketMQ 并不支持任意时间的延时,需要设置几个固定的延时等级,从 1s 到 2h 分别对应着等级 1 到 18,消息消费失败会进入延时消息队列,消息发送时间与设置的延时等级和重试次数有关,详见代码 SendMessageProcessor.java

private String messageDelayLevel = "1s 5s 10s 30s 1m 2m 3m 4m 5m 6m 7m 8m 9m 10m 20m 30m 1h 2h";

Broker 可以配置 messageDelayLevel,该属性是 Broker 的属性,不属于某个 Topic

发消息时,可以设置延迟等级 msg.setDelayLevel(level),level 有以下三种情况:

- level == 0:消息为非延迟消息

- 1<=level<=maxLevel:消息延迟特定时间,例如 level==1,延迟 1s

- level > maxLevel:则 level== maxLevel,例如 level==20,延迟 2h

定时消息会暂存在名为 SCHEDULE_TOPIC_XXXX 的 Topic 中,并根据 delayTimeLevel 存入特定的 queue,队列的标识 queueId = delayTimeLevel – 1,即一个 queue 只存相同延迟的消息,保证具有相同发送延迟的消息能够顺序消费。Broker 会为每个延迟级别提交一个定时任务,调度地消费 SCHEDULE_TOPIC_XXXX,将消息写入真实的 Topic

注意:定时消息在第一次写入和调度写入真实 Topic 时都会计数,因此发送数量、tps 都会变高

代码实现

提交了一个订单就可以发送一个延时消息,1h 后去检查这个订单的状态,如果还是未付款就取消订单释放库存

public class ScheduledMessageProducer {

public static void main(String[] args) throws Exception {

// 实例化一个生产者来产生延时消息

DefaultMQProducer producer = new DefaultMQProducer("ExampleProducerGroup");

producer.setNamesrvAddr("127.0.0.1:9876");

// 启动生产者

producer.start();

int totalMessagesToSend = 100;

for (int i = 0; i < totalMessagesToSend; i++) {

Message message = new Message("DelayTopic", ("Hello scheduled message " + i).getBytes());

// 设置延时等级3,这个消息将在10s之后发送(现在只支持固定的几个时间,详看delayTimeLevel)

message.setDelayTimeLevel(3);

// 发送消息

producer.send(message);

}

// 关闭生产者

producer.shutdown();

}

}

public class ScheduledMessageConsumer {

public static void main(String[] args) throws Exception {

// 实例化消费者

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("ExampleConsumer");

consumer.setNamesrvAddr("127.0.0.1:9876");

// 订阅Topics

consumer.subscribe("DelayTopic", "*");

// 注册消息监听者

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> messages, ConsumeConcurrentlyContext context) {

for (MessageExt message : messages) {

// 打印延迟的时间段

System.out.println("Receive message[msgId=" + message.getMsgId() + "] " + (System.currentTimeMillis() - message.getBornTimestamp()) + "ms later");}

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

// 启动消费者

consumer.start();

}

}

批量消息

批量发送消息能显著提高传递小消息的性能,限制是这些批量消息应该有相同的 topic,相同的 waitStoreMsgOK,而且不能是延时消息,并且这一批消息的总大小不应超过 4MB

public class Producer {

public static void main(String[] args) throws Exception {

DefaultMQProducer producer = new DefaultMQProducer("ExampleProducerGroup")

producer.setNamesrvAddr("127.0.0.1:9876");

//启动producer

producer.start();

List<Message> msgs = new ArrayList<Message>();

// 创建消息对象,指定主题Topic、Tag和消息体

Message msg1 = new Message("BatchTopic", "Tag1", ("Hello World" + 1).getBytes());

Message msg2 = new Message("BatchTopic", "Tag1", ("Hello World" + 2).getBytes());

Message msg3 = new Message("BatchTopic", "Tag1", ("Hello World" + 3).getBytes());

msgs.add(msg1);

msgs.add(msg2);

msgs.add(msg3);

// 发送消息

SendResult result = producer.send(msgs);

System.out.println("发送结果:" + result);

// 关闭生产者producer

producer.shutdown();

}

}

当发送大批量数据时,可能不确定消息是否超过了大小限制(4MB),所以需要将消息列表分割一下

public class ListSplitter implements Iterator<List<Message>> {

private final int SIZE_LIMIT = 1024 * 1024 * 4;

private final List<Message> messages;

private int currIndex;

public ListSplitter(List<Message> messages) {

this.messages = messages;

}

@Override

public boolean hasNext() {

return currIndex < messages.size();

}

@Override

public List<Message> next() {

int startIndex = getStartIndex();

int nextIndex = startIndex;

int totalSize = 0;

for (; nextIndex < messages.size(); nextIndex++) {

Message message = messages.get(nextIndex);

int tmpSize = calcMessageSize(message);

// 单个消息超过了最大的限制

if (tmpSize + totalSize > SIZE_LIMIT) {

break;

} else {

totalSize += tmpSize;

}

}

List<Message> subList = messages.subList(startIndex, nextIndex);

currIndex = nextIndex;

return subList;

}

private int getStartIndex() {

Message currMessage = messages.get(currIndex);

int tmpSize = calcMessageSize(currMessage);

while (tmpSize > SIZE_LIMIT) {

currIndex += 1;

Message message = messages.get(curIndex);

tmpSize = calcMessageSize(message);

}

return currIndex;

}

private int calcMessageSize(Message message) {

int tmpSize = message.getTopic().length() + message.getBody().length;

Map<String, String> properties = message.getProperties();

for (Map.Entry<String, String> entry : properties.entrySet()) {

tmpSize += entry.getKey().length() + entry.getValue().length();

}

tmpSize = tmpSize + 20; // 增加⽇日志的开销20字节

return tmpSize;

}

public static void main(String[] args) {

//把大的消息分裂成若干个小的消息

ListSplitter splitter = new ListSplitter(messages);

while (splitter.hasNext()) {

try {

List<Message> listItem = splitter.next();

producer.send(listItem);

} catch (Exception e) {

e.printStackTrace();

//处理error

}

}

}

}

过滤消息

基本语法

RocketMQ 定义了一些基本语法来支持过滤特性,可以很容易地扩展:

- 数值比较,比如:>,>=,<,<=,BETWEEN,=

- 字符比较,比如:=,<>,IN

- IS NULL 或者 IS NOT NULL

- 逻辑符号 AND,OR,NOT

常量支持类型为:

- 数值,比如 123,3.1415

- 字符,比如 ‘abc’,必须用单引号包裹起来

- NULL,特殊的常量

- 布尔值,TRUE 或 FALSE

只有使用 push 模式的消费者才能用使用 SQL92 标准的 sql 语句,接口如下:

public void subscribe(final String topic, final MessageSelector messageSelector)

例如:消费者接收包含 TAGA 或 TAGB 或 TAGC 的消息

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("CID_EXAMPLE");

consumer.subscribe("TOPIC", "TAGA || TAGB || TAGC");

原理解析

RocketMQ 分布式消息队列的消息过滤方式是在 Consumer 端订阅消息时再做消息过滤的,所以是在 Broker 端实现的,优点是减少了对于 Consumer 无用消息的网络传输,缺点是增加了 Broker 的负担,而且实现相对复杂

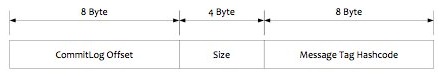

RocketMQ 在 Producer 端写入消息和在 Consumer 端订阅消息采用分离存储的机制实现,Consumer 端订阅消息是需要通过 ConsumeQueue 这个消息消费的逻辑队列拿到一个索引,然后再从 CommitLog 里面读取真正的消息实体内容

ConsumeQueue 的存储结构如下,有 8 个字节存储的 Message Tag 的哈希值,基于 Tag 的消息过滤就是基于这个字段

-

Tag 过滤:Consumer 端订阅消息时指定 Topic 和 TAG,然后将订阅请求构建成一个 SubscriptionData,发送一个 Pull 消息的请求给 Broker 端。Broker 端用这些数据先构建一个 MessageFilter,然后传给文件存储层 Store。Store 从 ConsumeQueue 读取到一条记录后,会用它记录的消息 tag hash 值去做过滤。因为在服务端只是根据 hashcode 进行判断,无法精确对 tag 原始字符串进行过滤,所以消费端拉取到消息后,还需要对消息的原始 tag 字符串进行比对,如果不同,则丢弃该消息,不进行消息消费

-

SQL92 过滤:工作流程和 Tag 过滤大致一样,只是在 Store 层的具体过滤方式不一样。真正的 SQL expression 的构建和执行由 rocketmq-filter 模块负责,每次过滤都去执行 SQL 表达式会影响效率,所以 RocketMQ 使用了 BloomFilter 来避免了每次都去执行

代码实现

发送消息时,通过 putUserProperty 来设置消息的属性,SQL92 的表达式上下文为消息的属性

public class Producer {

public static void main(String[] args) throws Exception {

DefaultMQProducer producer = new DefaultMQProducer("please_rename_unique_group_name");

producer.setNamesrvAddr("127.0.0.1:9876");

producer.start();

for (int i = 0; i < 10; i++) {

Message msg = new Message("FilterTopic", "tag",

("Hello RocketMQ " + i).getBytes(RemotingHelper.DEFAULT_CHARSET));

// 设置一些属性

msg.putUserProperty("i", String.valueOf(i));

SendResult sendResult = producer.send(msg);

}

producer.shutdown();

}

}

使用 SQL 筛选过滤消息:

public class Consumer {

public static void main(String[] args) throws Exception {

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("please_rename_unique_group_name");

consumer.setNamesrvAddr("127.0.0.1:9876");

// 过滤属性大于 5 的消息

consumer.subscribe("FilterTopic", MessageSelector.bySql("i>5"));

// 设置回调函数,处理消息

consumer.registerMessageListener(new MessageListenerConcurrently() {

//接受消息内容

@Override

public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs, ConsumeConcurrentlyContext context) {

for (MessageExt msg : msgs) {

System.out.println("consumeThread=" + Thread.currentThread().getName() + "," + new String(msg.getBody()));

}

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

// 启动消费者consumer

consumer.start();

}

}

事务消息

工作流程

RocketMQ 支持分布式事务消息,采用了 2PC 的思想来实现了提交事务消息,同时增加一个补偿逻辑来处理二阶段超时或者失败的消息,如下图所示:

事务消息的大致方案分为两个流程:正常事务消息的发送及提交、事务消息的补偿流程

-

事务消息发送及提交:

-

发送消息(Half 消息),服务器将消息的主题和队列改为半消息状态,并放入半消息队列

-

服务端响应消息写入结果(如果写入失败,此时 Half 消息对业务不可见)

-

根据发送结果执行本地事务

-

根据本地事务状态执行 Commit 或者 Rollback

-

-

补偿机制:用于解决消息 Commit 或者 Rollback 发生超时或者失败的情况,比如出现网络问题

- Broker 服务端通过对比 Half 消息和 Op 消息,对未确定状态的消息推进 CheckPoint

- 没有 Commit/Rollback 的事务消息,服务端根据根据半消息的生产者组,到 ProducerManager 中获取生产者(同一个 Group 的 Producer)的会话通道,发起一次回查(单向请求)

- Producer 收到回查消息,检查事务消息状态表内对应的本地事务的状态

- 根据本地事务状态,重新 Commit 或者 Rollback

RocketMQ 并不会无休止的进行事务状态回查,最大回查 15 次,如果 15 次回查还是无法得知事务状态,则默认回滚该消息,

回查服务:

TransactionalMessageCheckService#run

两阶段

一阶段

事务消息相对普通消息最大的特点就是一阶段发送的消息对用户是不可见的,因为对于 Half 消息,会备份原消息的主题与消息消费队列,然后改变主题为 RMQ_SYS_TRANS_HALF_TOPIC,由于消费组未订阅该主题,故消费端无法消费 Half 类型的消息

RocketMQ 会开启一个定时任务,从 Topic 为 RMQ_SYS_TRANS_HALF_TOPIC 中拉取消息进行消费,根据生产者组获取一个服务提供者发送回查事务状态请求,根据事务状态来决定是提交或回滚消息

RocketMQ 的具体实现策略:如果写入的是事务消息,对消息的 Topic 和 Queue 等属性进行替换,同时将原来的 Topic 和 Queue 信息存储到消息的属性中,因为消息的主题被替换,所以消息不会转发到该原主题的消息消费队列,消费者无法感知消息的存在,不会消费

二阶段

一阶段写入不可见的消息后,二阶段操作:

-

如果执行 Commit 操作,则需要让消息对用户可见,构建出 Half 消息的索引。一阶段的 Half 消息写到一个特殊的 Topic,构建索引时需要读取出 Half 消息,然后通过一次普通消息的写入操作将 Topic 和 Queue 替换成真正的目标 Topic 和 Queue,生成一条对用户可见的消息。其实就是利用了一阶段存储的消息的内容,在二阶段时恢复出一条完整的普通消息,然后走一遍消息写入流程

-

如果是 Rollback 则需要撤销一阶段的消息,因为消息本就不可见,所以并不需要真正撤销消息(实际上 RocketMQ 也无法去删除一条消息,因为是顺序写文件的)。RocketMQ 为了区分这条消息没有确定状态的消息,采用 Op 消息标识已经确定状态的事务消息(Commit 或者 Rollback)

事务消息无论是 Commit 或者 Rollback 都会记录一个 Op 操作,两者的区别是 Commit 相对于 Rollback 在写入 Op 消息前将原消息的主题和队列恢复。如果一条事务消息没有对应的 Op 消息,说明这个事务的状态还无法确定(可能是二阶段失败了)

RocketMQ 将 Op 消息写入到全局一个特定的 Topic 中,通过源码中的方法 TransactionalMessageUtil.buildOpTopic(),这个主题是一个内部的 Topic(像 Half 消息的 Topic 一样),不会被用户消费。Op 消息的内容为对应的 Half 消息的存储的 Offset,这样通过 Op 消息能索引到 Half 消息

基本使用

使用方式

事务消息共有三种状态,提交状态、回滚状态、中间状态:

- TransactionStatus.CommitTransaction:提交事务,允许消费者消费此消息。

- TransactionStatus.RollbackTransaction:回滚事务,代表该消息将被删除,不允许被消费

- TransactionStatus.Unknown:中间状态,代表需要检查消息队列来确定状态

使用限制:

- 事务消息不支持延时消息和批量消息

- Broker 配置文件中的参数

transactionTimeout为特定时间,事务消息将在特定时间长度之后被检查。当发送事务消息时,还可以通过设置用户属性CHECK_IMMUNITY_TIME_IN_SECONDS来改变这个限制,该参数优先于transactionTimeout参数 - 为了避免单个消息被检查太多次而导致半队列消息累积,默认将单个消息的检查次数限制为 15 次,开发者可以通过 Broker 配置文件的

transactionCheckMax参数来修改此限制。如果已经检查某条消息超过 N 次(N =transactionCheckMax), 则 Broker 将丢弃此消息,在默认情况下会打印错误日志。可以通过重写AbstractTransactionalMessageCheckListener类来修改这个行为 - 事务性消息可能不止一次被检查或消费

- 提交给用户的目标主题消息可能会失败,可以查看日志的记录。事务的高可用性通过 RocketMQ 本身的高可用性机制来保证,如果希望事务消息不丢失、并且事务完整性得到保证,可以使用同步的双重写入机制

- 事务消息的生产者 ID 不能与其他类型消息的生产者 ID 共享。与其他类型的消息不同,事务消息允许反向查询,MQ 服务器能通过消息的生产者 ID 查询到消费者

代码实现

实现事务的监听接口,当发送半消息成功时:

executeLocalTransaction方法来执行本地事务,返回三个事务状态之一checkLocalTransaction方法检查本地事务状态,响应消息队列的检查请求,返回三个事务状态之一

public class TransactionListenerImpl implements TransactionListener {

private AtomicInteger transactionIndex = new AtomicInteger(0);

private ConcurrentHashMap<String, Integer> localTrans = new ConcurrentHashMap<>();

@Override

public LocalTransactionState executeLocalTransaction(Message msg, Object arg) {

int value = transactionIndex.getAndIncrement();

int status = value % 3;

// 将事务ID和状态存入 map 集合

localTrans.put(msg.getTransactionId(), status);

return LocalTransactionState.UNKNOW;

}

@Override

public LocalTransactionState checkLocalTransaction(MessageExt msg) {

// 从 map 集合读出当前事务对应的状态

Integer status = localTrans.get(msg.getTransactionId());

if (null != status) {

switch (status) {

case 0:

return LocalTransactionState.UNKNOW;

case 1:

return LocalTransactionState.COMMIT_MESSAGE;

case 2:

return LocalTransactionState.ROLLBACK_MESSAGE;

}

}

return LocalTransactionState.COMMIT_MESSAGE;

}

}

使用 TransactionMQProducer 类创建事务性生产者,并指定唯一的 ProducerGroup,就可以设置自定义线程池来处理这些检查请求,执行本地事务后,需要根据执行结果对消息队列进行回复

public class Producer {

public static void main(String[] args) throws MQClientException, InterruptedException {

// 创建消息生产者

TransactionMQProducer producer = new TransactionMQProducer("please_rename_unique_group_name");

ExecutorService executorService = new ThreadPoolExecutor(2, 5, 100, TimeUnit.SECONDS);

producer.setExecutorService(executorService);

// 创建事务监听器

TransactionListener transactionListener = new TransactionListenerImpl();

// 生产者的监听器

producer.setTransactionListener(transactionListener);

// 启动生产者

producer.start();

String[] tags = new String[] {"TagA", "TagB", "TagC", "TagD", "TagE"};

for (int i = 0; i < 10; i++) {

try {

Message msg = new Message("TransactionTopic", tags[i % tags.length], "KEY" + i,

("Hello RocketMQ " + i).getBytes(RemotingHelper.DEFAULT_CHARSET));

// 发送消息

SendResult sendResult = producer.sendMessageInTransaction(msg, null);

System.out.printf("%s%n", sendResult);

Thread.sleep(10);

} catch (MQClientException | UnsupportedEncodingException e) {

e.printStackTrace();

}

}

//Thread.sleep(1000000);

//producer.shutdown();暂时不关闭

}

}

消费者代码和前面的实例相同的

系统特性

工作流程

模块介绍

NameServer 是一个简单的 Topic 路由注册中心,支持 Broker 的动态注册与发现,生产者或消费者能够通过名字服务查找各主题相应的 Broker IP 列表

NameServer 主要包括两个功能:

- Broker 管理,NameServer 接受 Broker 集群的注册信息,保存下来作为路由信息的基本数据,提供心跳检测机制检查 Broker 是否还存活,每 10 秒清除一次两小时没有活跃的 Broker

- 路由信息管理,每个 NameServer 将保存关于 Broker 集群的整个路由信息和用于客户端查询的队列信息,然后 Producer 和 Conumser 通过 NameServer 就可以知道整个 Broker 集群的路由信息,从而进行消息的投递和消费

NameServer 特点:

- NameServer 通常是集群的方式部署,各实例间相互不进行信息通讯

- Broker 向每一台 NameServer(集群)注册自己的路由信息,所以每个 NameServer 实例上面都保存一份完整的路由信息

- 当某个 NameServer 因某种原因下线了,Broker 仍可以向其它 NameServer 同步其路由信息

BrokerServer 主要负责消息的存储、投递和查询以及服务高可用保证,在 RocketMQ 系统中接收从生产者发送来的消息并存储、同时为消费者的拉取请求作准备,也存储消息相关的元数据,包括消费者组、消费进度偏移和主题和队列消息等

Broker 包含了以下几个重要子模块:

-

Remoting Module:整个 Broker 的实体,负责处理来自 Clients 端的请求

-

Client Manager:负责管理客户端(Producer/Consumer)和维护 Consumer 的 Topic 订阅信息

-

Store Service:提供方便简单的 API 接口处理消息存储到物理硬盘和查询功能

-

HA Service:高可用服务,提供 Master Broker 和 Slave Broker 之间的数据同步功能

-

Index Service:根据特定的 Message key 对投递到 Broker 的消息进行索引服务,以提供消息的快速查询

总体流程

RocketMQ 的工作流程:

- 启动 NameServer 监听端口,等待 Broker、Producer、Consumer 连上来,相当于一个路由控制中心

- Broker 启动,跟所有的 NameServer 保持长连接,每隔 30s 时间向 NameServer 上报 Topic 路由信息(心跳包)。心跳包中包含当前 Broker 信息(IP、端口等)以及存储所有 Topic 信息。注册成功后,NameServer 集群中就有 Topic 跟 Broker 的映射关系

- 收发消息前,先创建 Topic,创建 Topic 时需要指定该 Topic 要存储在哪些 Broker 上,也可以在发送消息时自动创建 Topic

- Producer 启动时先跟 NameServer 集群中的其中一台建立长连接,并从 NameServer 中获取当前发送的 Topic 存在哪些 Broker 上,同时 Producer 会默认每隔 30s 向 NameServer 定时拉取一次路由信息

- Producer 发送消息时,根据消息的 Topic 从本地缓存的 TopicPublishInfoTable 获取路由信息,如果没有则会从 NameServer 上重新拉取并更新,轮询队列列表并选择一个队列 MessageQueue,然后与队列所在的 Broker 建立长连接,向 Broker 发消息

- Consumer 跟 Producer 类似,跟其中一台 NameServer 建立长连接,定时获取路由信息,根据当前订阅 Topic 存在哪些 Broker 上,直接跟 Broker 建立连接通道,在完成客户端的负载均衡后,选择其中的某一个或者某几个 MessageQueue 来拉取消息并进行消费

生产消费

At least Once:至少一次,指每个消息必须投递一次,Consumer 先 Pull 消息到本地,消费完成后才向服务器返回 ACK,如果没有消费一定不会 ACK 消息

回溯消费:指 Consumer 已经消费成功的消息,由于业务上需求需要重新消费,Broker 在向 Consumer 投递成功消息后,消息仍然需要保留。并且重新消费一般是按照时间维度,例如由于 Consumer 系统故障,恢复后需要重新消费 1 小时前的数据,RocketMQ 支持按照时间回溯消费,时间维度精确到毫秒

分布式队列因为有高可靠性的要求,所以数据要进行持久化存储

- 消息生产者发送消息

- MQ 收到消息,将消息进行持久化,在存储中新增一条记录

- 返回 ACK 给生产者

- MQ push 消息给对应的消费者,然后等待消费者返回 ACK

- 如果消息消费者在指定时间内成功返回 ACK,那么 MQ 认为消息消费成功,在存储中删除消息;如果 MQ 在指定时间内没有收到 ACK,则认为消息消费失败,会尝试重新 push 消息,重复执行 4、5、6 步骤

- MQ 删除消息

存储机制

存储结构

RocketMQ 中 Broker 负责存储消息转发消息,所以以下的结构是存储在 Broker Server 上的,生产者和消费者与 Broker 进行消息的收发是通过主题对应的 Message Queue 完成,类似于通道

RocketMQ 消息的存储是由 ConsumeQueue 和 CommitLog 配合完成 的,CommitLog 是消息真正的物理存储文件,ConsumeQueue 是消息的逻辑队列,类似数据库的索引节点,存储的是指向物理存储的地址。每个 Topic 下的每个 Message Queue 都有一个对应的 ConsumeQueue 文件

每条消息都会有对应的索引信息,Consumer 通过 ConsumeQueue 这个结构来读取消息实体内容

- CommitLog:消息主体以及元数据的存储主体,存储 Producer 端写入的消息内容,消息内容不是定长的。消息主要是顺序写入日志文件,单个文件大小默认 1G,偏移量代表下一次写入的位置,当文件写满了就继续写入下一个文件

- ConsumerQueue:消息消费队列,存储消息在 CommitLog 的索引。RocketMQ 消息消费时要遍历 CommitLog 文件,并根据主题 Topic 检索消息,这是非常低效的。引入 ConsumeQueue 作为消费消息的索引,保存了指定 Topic 下的队列消息在 CommitLog 中的起始物理偏移量 offset,消息大小 size 和消息 Tag 的 HashCode 值,每个 ConsumeQueue 文件大小约 5.72M

- IndexFile:为了消息查询提供了一种通过 Key 或时间区间来查询消息的方法,通过 IndexFile 来查找消息的方法不影响发送与消费消息的主流程。IndexFile 的底层存储为在文件系统中实现的 HashMap 结构,故 RocketMQ 的索引文件其底层实现为 hash 索引

RocketMQ 采用的是混合型的存储结构,即为 Broker 单个实例下所有的队列共用一个日志数据文件(CommitLog)来存储,多个 Topic 的消息实体内容都存储于一个 CommitLog 中。混合型存储结构针对 Producer 和 Consumer 分别采用了数据和索引部分相分离的存储结构,Producer 发送消息至 Broker 端,然后 Broker 端使用同步或者异步的方式对消息刷盘持久化,保存至 CommitLog 中。只要消息被持久化至磁盘文件 CommitLog 中,Producer 发送的消息就不会丢失,Consumer 也就肯定有机会去消费这条消息

服务端支持长轮询模式,当消费者无法拉取到消息后,可以等下一次消息拉取,Broker 允许等待 30s 的时间,只要这段时间内有新消息到达,将直接返回给消费端。RocketMQ 的具体做法是,使用 Broker 端的后台服务线程 ReputMessageService 不停地分发请求并异步构建 ConsumeQueue(逻辑消费队列)和 IndexFile(索引文件)数据

内存映射

操作系统分为用户态和内核态,文件操作、网络操作需要涉及这两种形态的切换,需要进行数据复制。一台服务器把本机磁盘文件的内容发送到客户端,分为两个步骤:

-

read:读取本地文件内容

-

write:将读取的内容通过网络发送出去

补充:Prog → NET → I/O → 零拷贝部分的笔记详解相关内容

通过使用 mmap 的方式,可以省去向用户态的内存复制,RocketMQ 充分利用零拷贝技术,提高消息存盘和网络发送的速度

RocketMQ 通过 MappedByteBuffer 对文件进行读写操作,利用了 NIO 中的 FileChannel 模型将磁盘上的物理文件直接映射到用户态的内存地址中,将对文件的操作转化为直接对内存地址进行操作,从而极大地提高了文件的读写效率

MappedByteBuffer 内存映射的方式限制一次只能映射 1.5~2G 的文件至用户态的虚拟内存,所以 RocketMQ 默认设置单个 CommitLog 日志数据文件为 1G。RocketMQ 的文件存储使用定长结构来存储,方便一次将整个文件映射至内存

页面缓存

页缓存(PageCache)是 OS 对文件的缓存,每一页的大小通常是 4K,用于加速对文件的读写。因为 OS 将一部分的内存用作 PageCache,所以程序对文件进行顺序读写的速度几乎接近于内存的读写速度

- 对于数据的写入,OS 会先写入至 Cache 内,随后通过异步的方式由 pdflush 内核线程将 Cache 内的数据刷盘至物理磁盘上

- 对于数据的读取,如果一次读取文件时出现未命中 PageCache 的情况,OS 从物理磁盘上访问读取文件的同时,会顺序对其他相邻块的数据文件进行预读取(局部性原理,最大 128K)

在 RocketMQ 中,ConsumeQueue 逻辑消费队列存储的数据较少,并且是顺序读取,在 PageCache 机制的预读取作用下,Consume Queue 文件的读性能几乎接近读内存,即使在有消息堆积情况下也不会影响性能。但是 CommitLog 消息存储的日志数据文件读取内容时会产生较多的随机访问读取,严重影响性能。选择合适的系统 IO 调度算法和固态硬盘,比如设置调度算法为 Deadline,随机读的性能也会有所提升

刷盘机制

两种持久化的方案:

- 关系型数据库 DB:IO 读写性能比较差,如果 DB 出现故障,则 MQ 的消息就无法落盘存储导致线上故障,可靠性不高

- 文件系统:消息刷盘至所部署虚拟机/物理机的文件系统来做持久化,分为异步刷盘和同步刷盘两种模式。消息刷盘为消息存储提供了一种高效率、高可靠性和高性能的数据持久化方式,除非部署 MQ 机器本身或是本地磁盘挂了,一般不会出现无法持久化的问题

RocketMQ 采用文件系统的方式,无论同步还是异步刷盘,都使用顺序 IO,因为磁盘的顺序读写要比随机读写快很多

-

同步刷盘:只有在消息真正持久化至磁盘后 RocketMQ 的 Broker 端才会真正返回给 Producer 端一个成功的 ACK 响应,保障 MQ 消息的可靠性,但是性能上会有较大影响,一般适用于金融业务应用该模式较多

-

异步刷盘:利用 OS 的 PageCache,只要消息写入内存 PageCache 即可将成功的 ACK 返回给 Producer 端,降低了读写延迟,提高了 MQ 的性能和吞吐量。消息刷盘采用后台异步线程提交的方式进行,当内存里的消息量积累到一定程度时,触发写磁盘动作

通过 Broker 配置文件里的 flushDiskType 参数设置采用什么方式,可以配置成 SYNC_FLUSH、ASYNC_FLUSH 中的一个

官方文档:https://github.com/apache/rocketmq/blob/master/docs/cn/design.md

集群设计

集群模式

常用的以下几种模式:

-

单 Master 模式:这种方式风险较大,一旦 Broker 重启或者宕机,会导致整个服务不可用

-

多 Master 模式:一个集群无 Slave,全是 Master

-

优点:配置简单,单个 Master 宕机或重启维护对应用无影响,在磁盘配置为 RAID10 时,即使机器宕机不可恢复情况下,由于 RAID10 磁盘非常可靠,消息也不会丢(异步刷盘丢失少量消息,同步刷盘一条不丢),性能最高

-

缺点:单台机器宕机期间,这台机器上未被消费的消息在机器恢复之前不可订阅,消息实时性会受到影响

-

-

多 Master 多 Slave 模式(同步):每个 Master 配置一个 Slave,有多对 Master-Slave,HA 采用同步双写方式,即只有主备都写成功,才向应用返回成功

- 优点:数据与服务都无单点故障,Master 宕机情况下,消息无延迟,服务可用性与数据可用性都非常高

- 缺点:性能比异步复制略低(大约低 10% 左右),发送单个消息的 RT 略高,目前不能实现主节点宕机,备机自动切换为主机

-

多 Master 多 Slave 模式(异步):HA 采用异步复制的方式,会造成主备有短暂的消息延迟(毫秒级别)

- 优点:即使磁盘损坏,消息丢失的非常少,且消息实时性不会受影响,同时 Master 宕机后,消费者仍然可以从 Slave 消费,而且此过程对应用透明,不需要人工干预,性能同多 Master 模式几乎一样

- 缺点:Master 宕机,磁盘损坏情况下会丢失少量消息

集群架构

RocketMQ 网络部署特点:

-

NameServer 是一个几乎无状态节点,节点之间相互独立,无任何信息同步

-

Broker 部署相对复杂,Broker 分为 Master 与 Slave,Master 可以部署多个,一个 Master 可以对应多个 Slave,但是一个 Slave 只能对应一个 Master,Master 与 Slave 的对应关系通过指定相同 BrokerName、不同 BrokerId 来定义,BrokerId 为 0 是 Master,非 0 表示 Slave。每个 Broker 与 NameServer 集群中的所有节点建立长连接,定时注册 Topic 信息到所有 NameServer

说明:部署架构上也支持一 Master 多 Slave,但只有 BrokerId=1 的从服务器才会参与消息的读负载(读写分离)

-

Producer 与 NameServer 集群中的其中一个节点(随机选择)建立长连接,定期从 NameServer 获取 Topic 路由信息,并向提供 Topic 服务的 Master 建立长连接,且定时向 Master 发送心跳。Producer 完全无状态,可集群部署

-

Consumer 与 NameServer 集群中的其中一个节点(随机选择)建立长连接,定期从 NameServer 获取 Topic 路由信息,并向提供 Topic 服务的 Master、Slave 建立长连接,且定时向 Master、Slave 发送心跳

Consumer 既可以从 Master 订阅消息,也可以从 Slave 订阅消息,在向 Master 拉取消息时,Master 服务器会根据拉取偏移量与最大偏移量的距离(判断是否读老消息,产生读 I/O),以及从服务器是否可读等因素建议下一次是从 Master 还是 Slave 拉取

官方文档:https://github.com/apache/rocketmq/blob/master/docs/cn/architecture.md

高可用性

NameServer 节点是无状态的,且各个节点直接的数据是一致的,部分 NameServer 不可用也可以保证 MQ 服务正常运行

BrokerServer 的高可用通过 Master 和 Slave 的配合:

-

Slave 只负责读,当 Master 不可用,对应的 Slave 仍能保证消息被正常消费

-

配置多组 Master-Slave 组,其他的 Master-Slave 组也会保证消息的正常发送和消费

-

目前不支持把 Slave 自动转成 Master,需要手动停止 Slave 角色的 Broker,更改配置文件,用新的配置文件启动 Broker

所以需要配置多个 Master 保证可用性,否则一个 Master 挂了导致整体系统的写操作不可用

生产端的高可用:在创建 Topic 的时候,把 Topic 的多个 Message Queue 创建在多个 Broker 组上(相同 Broker 名称,不同 brokerId 的机器),当一个 Broker 组的 Master 不可用后,其他组的 Master 仍然可用,Producer 仍然可以发送消息

消费端的高可用:在 Consumer 的配置文件中,并不需要设置是从 Master Broker 读还是从 Slave 读,当 Master 不可用或者繁忙的时候,Consumer 会被自动切换到从 Slave 读。有了自动切换的机制,当一个 Master 机器出现故障后,Consumer 仍然可以从 Slave 读取消息,不影响 Consumer 程序,达到了消费端的高可用性

主从复制

如果一个 Broker 组有 Master 和 Slave,消息需要从 Master 复制到 Slave 上,有同步和异步两种复制方式:

-

同步复制方式:Master 和 Slave 均写成功后才反馈给客户端写成功状态(写 Page Cache)。在同步复制方式下,如果 Master 出故障, Slave 上有全部的备份数据,容易恢复,但是同步复制会增大数据写入延迟,降低系统吞吐量

-

异步复制方式:只要 Master 写成功,即可反馈给客户端写成功状态,系统拥有较低的延迟和较高的吞吐量,但是如果 Master 出了故障,有些数据因为没有被写入 Slave,有可能会丢失

同步复制和异步复制是通过 Broker 配置文件里的 brokerRole 参数进行设置的,可以设置成 ASYNC_MASTE、RSYNC_MASTER、SLAVE 三个值中的一个

一般把刷盘机制配置成 ASYNC_FLUSH,主从复制为 SYNC_MASTER,这样即使有一台机器出故障,仍然能保证数据不丢

RocketMQ 支持消息的高可靠,影响消息可靠性的几种情况:

- Broker 非正常关闭

- Broker 异常 Crash

- OS Crash

- 机器掉电,但是能立即恢复供电情况

- 机器无法开机(可能是 CPU、主板、内存等关键设备损坏)

- 磁盘设备损坏

前四种情况都属于硬件资源可立即恢复情况,RocketMQ 在这四种情况下能保证消息不丢,或者丢失少量数据(依赖刷盘方式)

后两种属于单点故障,且无法恢复,一旦发生,在此单点上的消息全部丢失。RocketMQ 在这两种情况下,通过主从异步复制,可保证 99% 的消息不丢,但是仍然会有极少量的消息可能丢失。通过同步双写技术可以完全避免单点,但是会影响性能,适合对消息可靠性要求极高的场合,RocketMQ 从 3.0 版本开始支持同步双写

一般而言,我们会建议采取同步双写 + 异步刷盘的方式,在消息的可靠性和性能间有一个较好的平衡

负载均衡

生产端

RocketMQ 中的负载均衡可以分为 Producer 端发送消息时候的负载均衡和 Consumer 端订阅消息的负载均衡

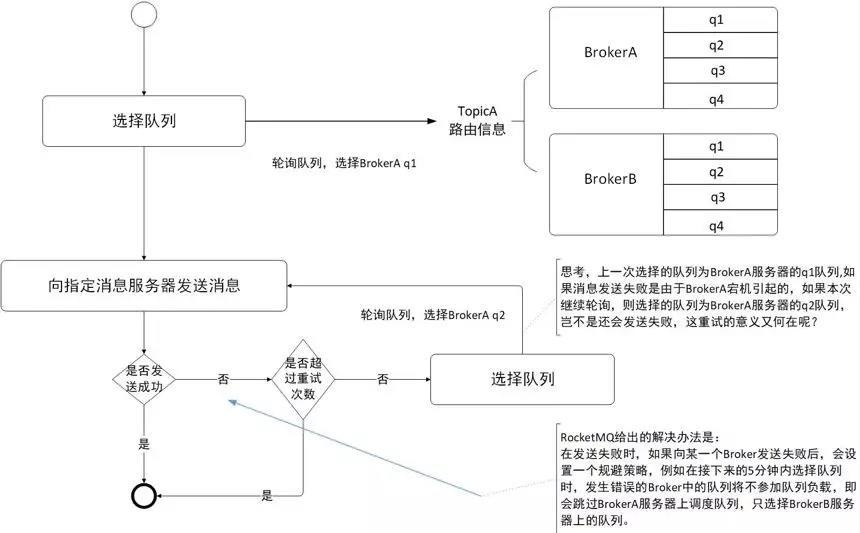

Producer 端在发送消息时,会先根据 Topic 找到指定的 TopicPublishInfo,在获取了 TopicPublishInfo 路由信息后,RocketMQ 的客户端在默认方式调用 selectOneMessageQueue() 方法从 TopicPublishInfo 中的 messageQueueList 中选择一个队列 MessageQueue 进行发送消息

默认会轮询所有的 Message Queue 发送,以让消息平均落在不同的 queue 上,而由于 queue可以散落在不同的 Broker,所以消息就发送到不同的 Broker 下,图中箭头线条上的标号代表顺序,发布方会把第一条消息发送至 Queue 0,然后第二条消息发送至 Queue 1,以此类推:

容错策略均在 MQFaultStrategy 这个类中定义,有一个 sendLatencyFaultEnable 开关变量:

- 如果开启,会在随机(只有初始化索引变量时才随机,正常都是递增)递增取模的基础上,再过滤掉 not available 的 Broker

- 如果关闭,采用随机递增取模的方式选择一个队列(MessageQueue)来发送消息

LatencyFaultTolerance 机制是实现消息发送高可用的核心关键所在,对之前失败的,按一定的时间做退避。例如上次请求的 latency 超过 550Lms,就退避 3000Lms;超过 1000L,就退避 60000L

消费端

在 RocketMQ 中,Consumer 端的两种消费模式(Push/Pull)都是基于拉模式来获取消息的,而在 Push 模式只是对 Pull 模式的一种封装,其本质实现为消息拉取线程在从服务器拉取到一批消息,提交到消息消费线程池后,又继续向服务器再次尝试拉取消息,如果未拉取到消息,则延迟一下又继续拉取

在两种基于拉模式的消费方式(Push/Pull)中,均需要 Consumer 端在知道从 Broker 端的哪一个消息队列中去获取消息,所以在 Consumer 端来做负载均衡,即 Broker 端中多个 MessageQueue 分配给同一个 Consumer Group 中的哪些 Consumer 消费

-

广播模式下要求一条消息需要投递到一个消费组下面所有的消费者实例,所以不存在负载均衡,在实现上,Consumer 分配 queue 时,所有 Consumer 都分到所有的 queue。

-

在集群消费模式下,每条消息只需要投递到订阅这个 Topic 的 Consumer Group 下的一个实例即可,RocketMQ 采用主动拉取的方式拉取并消费消息,在拉取的时候需要明确指定拉取哪一条 Message Queue

集群模式下,每当消费者实例的数量有变更,都会触发一次所有实例的负载均衡,这时候会按照 queue 的数量和实例的数量平均分配 queue 给每个实例。默认的分配算法是 AllocateMessageQueueAveragely:

还有一种平均的算法是 AllocateMessageQueueAveragelyByCircle,以环状轮流均分 queue 的形式:

集群模式下,queue 都是只允许分配一个实例,如果多个实例同时消费一个 queue 的消息,由于拉取哪些消息是 Consumer 主动控制的,会导致同一个消息在不同的实例下被消费多次

通过增加 Consumer 实例去分摊 queue 的消费,可以起到水平扩展的消费能力的作用。而当有实例下线时,会重新触发负载均衡,这时候原来分配到的 queue 将分配到其他实例上继续消费。但是如果 Consumer 实例的数量比 Message Queue 的总数量还多的话,多出来的 Consumer 实例将无法分到 queue,也就无法消费到消息,也就无法起到分摊负载的作用了,所以需要控制让 queue 的总数量大于等于 Consumer 的数量

原理解析

在 Consumer 启动后,会通过定时任务不断地向 RocketMQ 集群中的所有 Broker 实例发送心跳包。Broker 端在收到 Consumer 的心跳消息后,会将它维护在 ConsumerManager 的本地缓存变量 consumerTable,同时并将封装后的客户端网络通道信息保存在本地缓存变量 channelInfoTable 中,为 Consumer 端的负载均衡提供可以依据的元数据信息

Consumer 端实现负载均衡的核心类 RebalanceImpl

在 Consumer 实例的启动流程中的会启动 MQClientInstance 实例,完成负载均衡服务线程 RebalanceService 的启动(每隔 20s 执行一次负载均衡),RebalanceService 线程的 run() 方法最终调用的是 RebalanceImpl 类的 rebalanceByTopic() 方法,该方法是实现 Consumer 端负载均衡的核心。rebalanceByTopic() 方法会根据广播模式还是集群模式做不同的逻辑处理。主要看集群模式:

-

从 rebalanceImpl 实例的本地缓存变量 topicSubscribeInfoTable 中,获取该 Topic 主题下的消息消费队列集合 mqSet

-

根据 Topic 和 consumerGroup 为参数调用

mQClientFactory.findConsumerIdList()方法向 Broker 端发送获取该消费组下消费者 ID 列表的 RPC 通信请求(Broker 端基于前面 Consumer 端上报的心跳包数据而构建的 consumerTable 做出响应返回,业务请求码GET_CONSUMER_LIST_BY_GROUP) -

先对 Topic 下的消息消费队列、消费者 ID 排序,然后用消息队列分配策略算法(默认是消息队列的平均分配算法),计算出待拉取的消息队列。平均分配算法类似于分页的算法,将所有 MessageQueue 排好序类似于记录,将所有消费端 Consumer 排好序类似页数,并求出每一页需要包含的平均 size 和每个页面记录的范围 range,最后遍历整个 range 而计算出当前 Consumer 端应该分配到的记录(这里即为 MessageQueue)

-

调用 updateProcessQueueTableInRebalance() 方法,先将分配到的消息队列集合 mqSet 与 processQueueTable 做一个过滤比对

-

processQueueTable 标注的红色部分,表示与分配到的消息队列集合 mqSet 互不包含,将这些队列设置 Dropped 属性为 true,然后查看这些队列是否可以移除出 processQueueTable 缓存变量。具体执行 removeUnnecessaryMessageQueue() 方法,即每隔 1s 查看是否可以获取当前消费处理队列的锁,拿到的话返回 true;如果等待 1s 后,仍然拿不到当前消费处理队列的锁则返回 false。如果返回 true,则从 processQueueTable 缓存变量中移除对应的 Entry

-

processQueueTable 的绿色部分,表示与分配到的消息队列集合 mqSet 的交集,判断该 ProcessQueue 是否已经过期了,在 Pull 模式的不用管,如果是 Push 模式的,设置 Dropped 属性为 true,并且调用 removeUnnecessaryMessageQueue() 方法,像上面一样尝试移除 Entry

-

为过滤后的消息队列集合 mqSet 中每个 MessageQueue 创建 ProcessQueue 对象存入 RebalanceImpl 的 processQueueTable 队列中(其中调用 RebalanceImpl 实例的

computePullFromWhere(MessageQueue mq)方法获取该 MessageQueue 对象的下一个进度消费值 offset,随后填充至接下来要创建的 pullRequest 对象属性中),并创建拉取请求对象 pullRequest 添加到拉取列表 pullRequestList 中,最后执行 dispatchPullRequest() 方法,将 Pull 消息的请求对象 PullRequest 放入 PullMessageService 服务线程的阻塞队列 pullRequestQueue 中,待该服务线程取出后向 Broker 端发起 Pull 消息的请求对比下 RebalancePushImpl 和 RebalancePullImpl 两个实现类的 dispatchPullRequest() 方法,RebalancePullImpl 类里面的该方法为空

消息消费队列在同一消费组不同消费者之间的负载均衡,其核心设计理念是在一个消息消费队列在同一时间只允许被同一消费组内的一个消费者消费,一个消息消费者能同时消费多个消息队列

消息查询

查询方式

RocketMQ 支持按照两种维度进行消息查询:按照 Message ID 查询消息、按照 Message Key 查询消息

-

RocketMQ 中的 MessageID 的长度总共有 16 字节,其中包含了消息存储主机地址(IP 地址和端口),消息 Commit Log offset

实现方式:Client 端从 MessageID 中解析出 Broker 的地址(IP 地址和端口)和 Commit Log 的偏移地址,封装成一个 RPC 请求后通过 Remoting 通信层发送(业务请求码 VIEW_MESSAGE_BY_ID)。Broker 端走的是 QueryMessageProcessor,读取消息的过程用其中的 CommitLog 的 offset 和 size 去 CommitLog 中找到真正的记录并解析成一个完整的消息返回

-

按照 Message Key 查询消息,IndexFile 索引文件为提供了通过 Message Key 查询消息的服务

实现方式:通过 Broker 端的 QueryMessageProcessor 业务处理器来查询,读取消息的过程用 Topic 和 Key 找到 IndexFile 索引文件中的一条记录,根据其中的 CommitLog Offset 从 CommitLog 文件中读取消息的实体内容

索引机制

RocketMQ 的索引文件逻辑结构,类似 JDK 中 HashMap 的实现,具体结构如下:

IndexFile 文件的存储在 $HOME\store\index${fileName},文件名 fileName 是以创建时的时间戳命名,文件大小是固定的,等于 40+500W*4+2000W*20= 420000040 个字节大小。如果消息的 properties 中设置了 UNIQ_KEY 这个属性,就用 topic + “#” + UNIQ_KEY 作为 key 来做写入操作;如果消息设置了 KEYS 属性(多个 KEY 以空格分隔),也会用 topic + “#” + KEY 来做索引

整个 Index File 的结构如图,40 Byte 的 Header 用于保存一些总的统计信息,4*500W 的 Slot Table 并不保存真正的索引数据,而是保存每个槽位对应的单向链表的头指针,即一个 Index File 可以保存 2000W 个索引,20*2000W 是真正的索引数据

索引数据包含了 Key Hash/CommitLog Offset/Timestamp/NextIndex offset 这四个字段,一共 20 Byte

- NextIndex offset 即前面读出来的 slotValue,如果有 hash 冲突,就可以用这个字段将所有冲突的索引用链表的方式串起来

- Timestamp 记录的是消息 storeTimestamp 之间的差,并不是一个绝对的时间

参考文档:https://github.com/apache/rocketmq/blob/master/docs/cn/design.md

消息重试

消息重投

生产者在发送消息时,同步消息和异步消息失败会重投,oneway 没有任何保证。消息重投保证消息尽可能发送成功、不丢失,但当出现消息量大、网络抖动时,可能会造成消息重复;生产者主动重发、Consumer 负载变化也会导致重复消息

如下方法可以设置消息重投策略:

- retryTimesWhenSendFailed:同步发送失败重投次数,默认为 2,因此生产者会最多尝试发送 retryTimesWhenSendFailed + 1 次。不会选择上次失败的 Broker,尝试向其他 Broker 发送,最大程度保证消息不丢。超过重投次数抛出异常,由客户端保证消息不丢。当出现 RemotingException、MQClientException 和部分 MQBrokerException 时会重投

- retryTimesWhenSendAsyncFailed:异步发送失败重试次数,异步重试不会选择其他 Broker,仅在同一个 Broker 上做重试,不保证消息不丢

- retryAnotherBrokerWhenNotStoreOK:消息刷盘(主或备)超时或 slave 不可用(返回状态非 SEND_OK),是否尝试发送到其他 Broker,默认 false,十分重要消息可以开启

注意点:

- 如果同步模式发送失败,则选择到下一个 Broker,如果异步模式发送失败,则只会在当前 Broker 进行重试

- 发送消息超时时间默认 3000 毫秒,就不会再尝试重试

消息重试

Consumer 消费消息失败后,提供了一种重试机制,令消息再消费一次。Consumer 消费消息失败可以认为有以下几种情况:

- 由于消息本身的原因,例如反序列化失败,消息数据本身无法处理等。这种错误通常需要跳过这条消息,再消费其它消息,而这条失败的消息即使立刻重试消费,99% 也不成功,所以需要提供一种定时重试机制,即过 10 秒后再重试

- 由于依赖的下游应用服务不可用,例如 DB 连接不可用,外系统网络不可达等。这种情况即使跳过当前失败的消息,消费其他消息同样也会报错,这种情况建议应用 sleep 30s,再消费下一条消息,这样可以减轻 Broker 重试消息的压力

RocketMQ 会为每个消费组都设置一个 Topic 名称为 %RETRY%+consumerGroup 的重试队列(这个 Topic 的重试队列是针对消费组,而不是针对每个 Topic 设置的),用于暂时保存因为各种异常而导致 Consumer 端无法消费的消息

-

顺序消息的重试,当消费者消费消息失败后,消息队列 RocketMQ 会自动不断进行消息重试(每次间隔时间为 1 秒),这时应用会出现消息消费被阻塞的情况。所以在使用顺序消息时,必须保证应用能够及时监控并处理消费失败的情况,避免阻塞现象的发生

-

无序消息(普通、定时、延时、事务消息)的重试,可以通过设置返回状态达到消息重试的结果。无序消息的重试只针对集群消费方式生效,广播方式不提供失败重试特性,即消费失败后,失败消息不再重试,继续消费新的消息

无序消息情况下,因为异常恢复需要一些时间,会为重试队列设置多个重试级别,每个重试级别都有对应的重新投递延时,重试次数越多投递延时就越大。RocketMQ 对于重试消息的处理是先保存至 Topic 名称为 SCHEDULE_TOPIC_XXXX 的延迟队列中,后台定时任务按照对应的时间进行 Delay 后重新保存至 %RETRY%+consumerGroup 的重试队列中

消息队列 RocketMQ 默认允许每条消息最多重试 16 次,每次重试的间隔时间如下表示:

| 第几次重试 | 与上次重试的间隔时间 | 第几次重试 | 与上次重试的间隔时间 |

|---|---|---|---|

| 1 | 10 秒 | 9 | 7 分钟 |

| 2 | 30 秒 | 10 | 8 分钟 |

| 3 | 1 分钟 | 11 | 9 分钟 |

| 4 | 2 分钟 | 12 | 10 分钟 |

| 5 | 3 分钟 | 13 | 20 分钟 |

| 6 | 4 分钟 | 14 | 30 分钟 |

| 7 | 5 分钟 | 15 | 1 小时 |

| 8 | 6 分钟 | 16 | 2 小时 |

如果消息重试 16 次后仍然失败,消息将不再投递,如果严格按照上述重试时间间隔计算,某条消息在一直消费失败的前提下,将会在接下来的 4 小时 46 分钟之内进行 16 次重试,超过这个时间范围消息将不再重试投递

时间间隔不支持自定义配置,最大重试次数可通过自定义参数 MaxReconsumeTimes 取值进行配置,若配置超过 16 次,则超过的间隔时间均为 2 小时

说明:一条消息无论重试多少次,消息的 Message ID 是不会改变的

重试操作

集群消费方式下,消息消费失败后期望消息重试,需要在消息监听器接口的实现中明确进行配置(三种方式任选一种):

- 返回 Action.ReconsumeLater (推荐)

- 返回 null

- 抛出异常

public class MessageListenerImpl implements MessageListener {

@Override

public Action consume(Message message, ConsumeContext context) {

// 处理消息

doConsumeMessage(message);

//方式1:返回 Action.ReconsumeLater,消息将重试

return Action.ReconsumeLater;

//方式2:返回 null,消息将重试

return null;

//方式3:直接抛出异常, 消息将重试

throw new RuntimeException("Consumer Message exceotion");

}

}

集群消费方式下,消息失败后期望消息不重试,需要捕获消费逻辑中可能抛出的异常,最终返回 Action.CommitMessage,此后这条消息将不会再重试

public class MessageListenerImpl implements MessageListener {

@Override

public Action consume(Message message, ConsumeContext context) {

try {

doConsumeMessage(message);

} catch (Throwable e) {

// 捕获消费逻辑中的所有异常,并返回 Action.CommitMessage;

return Action.CommitMessage;

}

//消息处理正常,直接返回 Action.CommitMessage;

return Action.CommitMessage;

}

}

自定义消息最大重试次数,RocketMQ 允许 Consumer 启动的时候设置最大重试次数,重试时间间隔将按照如下策略:

- 最大重试次数小于等于 16 次,则重试时间间隔同上表描述

- 最大重试次数大于 16 次,超过 16 次的重试时间间隔均为每次 2 小时

Properties properties = new Properties();

// 配置对应 Group ID 的最大消息重试次数为 20 次

properties.put(PropertyKeyConst.MaxReconsumeTimes,"20");

Consumer consumer = ONSFactory.createConsumer(properties);

注意:

- 消息最大重试次数的设置对相同 Group ID 下的所有 Consumer 实例有效。例如只对相同 Group ID 下两个 Consumer 实例中的其中一个设置了 MaxReconsumeTimes,那么该配置对两个 Consumer 实例均生效

- 配置采用覆盖的方式生效,即最后启动的 Consumer 实例会覆盖之前的启动实例的配置

消费者收到消息后,可按照如下方式获取消息的重试次数:

public class MessageListenerImpl implements MessageListener {

@Override

public Action consume(Message message, ConsumeContext context) {

// 获取消息的重试次数

System.out.println(message.getReconsumeTimes());

return Action.CommitMessage;

}

}

死信队列

正常情况下无法被消费的消息称为死信消息(Dead-Letter Message),存储死信消息的特殊队列称为死信队列(Dead-Letter Queue)

当一条消息初次消费失败,消息队列 RocketMQ 会自动进行消息重试,达到最大重试次数后,若消费依然失败,则表明消费者在正常情况下无法正确地消费该消息,此时 RocketMQ 不会立刻将消息丢弃,而是将其发送到该消费者对应的死信队列中

死信消息具有以下特性:

- 不会再被消费者正常消费

- 有效期与正常消息相同,均为 3 天,3 天后会被自动删除,所以请在死信消息产生后的 3 天内及时处理

死信队列具有以下特性:

- 一个死信队列对应一个 Group ID, 而不是对应单个消费者实例

- 如果一个 Group ID 未产生死信消息,消息队列 RocketMQ 不会为其创建相应的死信队列

- 一个死信队列包含了对应 Group ID 产生的所有死信消息,不论该消息属于哪个 Topic

一条消息进入死信队列,需要排查可疑因素并解决问题后,可以在消息队列 RocketMQ 控制台重新发送该消息,让消费者重新消费一次

高可靠性

RocketMQ 消息丢失可能发生在以下三个阶段:

- 生产阶段:消息在 Producer 发送端创建出来,经过网络传输发送到 Broker 存储端

- 生产者得到一个成功的响应,就可以认为消息的存储和消息的消费都是可靠的

- 消息重投机制

- 存储阶段:消息在 Broker 端存储,如果是主备或者多副本,消息会在这个阶段被复制到其他的节点或者副本上

- 单点:刷盘机制(同步或异步)

- 主从:消息同步机制(异步复制或同步双写,主从复制章节详解)

- 过期删除:操作 CommitLog、ConsumeQueue 文件是基于文件内存映射机制,并且在启动的时候会将所有的文件加载,为了避免内存与磁盘的浪费,让磁盘能够循环利用,防止磁盘不足导致消息无法写入等引入了文件过期删除机制。最终使得磁盘水位保持在一定水平,最终保证新写入消息的可靠存储

- 消费阶段:Consumer 消费端从 Broker存储端拉取消息,经过网络传输发送到 Consumer 消费端上

- 消息重试机制来最大限度的保证消息的消费

- 消费失败的进行消息回退,重试次数过多的消息放入死信队列

推荐文章:https://cdn.modb.pro/db/394751

幂等消费

消息队列 RocketMQ 消费者在接收到消息以后,需要根据业务上的唯一 Key 对消息做幂等处理

At least Once 机制保证消息不丢失,但是可能会造成消息重复,RocketMQ 中无法避免消息重复(Exactly-Once),在互联网应用中,尤其在网络不稳定的情况下,几种情况:

-

发送时消息重复:当一条消息已被成功发送到服务端并完成持久化,此时出现了网络闪断或客户端宕机,导致服务端对客户端应答失败。此时生产者意识到消息发送失败并尝试再次发送消息,消费者后续会收到两条内容相同并且 Message ID 也相同的消息

-

投递时消息重复:消息消费的场景下,消息已投递到消费者并完成业务处理,当客户端给服务端反馈应答的时候网络闪断。为了保证消息至少被消费一次,消息队列 RocketMQ 的服务端将在网络恢复后再次尝试投递之前已被处理过的消息,消费者后续会收到两条内容相同并且 Message ID 也相同的消息

-

负载均衡时消息重复:当消息队列 RocketMQ 的 Broker 或客户端重启、扩容或缩容时,会触发 Rebalance,此时消费者可能会收到重复消息

处理方式:

-

因为 Message ID 有可能出现冲突(重复)的情况,所以真正安全的幂等处理,不建议以 Message ID 作为处理依据,最好的方式是以业务唯一标识作为幂等处理的关键依据,而业务的唯一标识可以通过消息 Key 进行设置:

Message message = new Message(); message.setKey("ORDERID_100"); SendResult sendResult = producer.send(message); -

订阅方收到消息时可以根据消息的 Key 进行幂等处理:

consumer.subscribe("ons_test", "*", new MessageListener() { public Action consume(Message message, ConsumeContext context) { String key = message.getKey() // 根据业务唯一标识的 key 做幂等处理 } });

流量控制

生产者流控,因为 Broker 处理能力达到瓶颈;消费者流控,因为消费能力达到瓶颈

生产者流控:

- CommitLog 文件被锁时间超过 osPageCacheBusyTimeOutMills 时,参数默认为 1000ms,返回流控

- 如果开启 transientStorePoolEnable == true,且 Broker 为异步刷盘的主机,且 transientStorePool 中资源不足,拒绝当前 send 请求,返回流控

- Broker 每隔 10ms 检查 send 请求队列头部请求的等待时间,如果超过 waitTimeMillsInSendQueue,默认 200ms,拒绝当前 send 请求,返回流控。

- Broker 通过拒绝 send 请求方式实现流量控制

注意:生产者流控,不会尝试消息重投

消费者流控:

- 消费者本地缓存消息数超过 pullThresholdForQueue 时,默认 1000

- 消费者本地缓存消息大小超过 pullThresholdSizeForQueue 时,默认 100MB

- 消费者本地缓存消息跨度超过 consumeConcurrentlyMaxSpan 时,默认 2000

消费者流控的结果是降低拉取频率

原理解析

Namesrv

服务启动

启动方法

NamesrvStartup 类中有 Namesrv 服务的启动方法:

public static void main(String[] args) {

// 如果启动时 使用 -c -p 设置参数了,这些参数存储在 args 中

main0(args);

}

public static NamesrvController main0(String[] args) {

try {

// 创建 namesrv 控制器,用来初始化 namesrv 启动 namesrv 关闭 namesrv

NamesrvController controller = createNamesrvController(args);

// 启动 controller

start(controller);

return controller;

} catch (Throwable e) {

// 出现异常,停止系统

System.exit(-1);

}

return null;

}

NamesrvStartup#createNamesrvController:读取配置信息,初始化 Namesrv 控制器

-

ServerUtil.parseCmdLine("mqnamesrv", args, buildCommandlineOptions(options),..):解析启动时的参数信息 -

namesrvConfig = new NamesrvConfig():创建 Namesrv 配置对象private String rocketmqHome:获取 ROCKETMQ_HOME 值private boolean orderMessageEnable = false:顺序消息功能是否开启

-

nettyServerConfig = new NettyServerConfig():Netty 的服务器配置对象 -

nettyServerConfig.setListenPort(9876):Namesrv 服务器的监听端口设置为 9876 -

if (commandLine.hasOption('c')):读取命令行 -c 的参数值in = new BufferedInputStream(new FileInputStream(file)):读取指定目录的配置文件properties.load(in):将配置文件信息加载到 properties 对象,相关属性会复写到 Namesrv 配置和 Netty 配置对象namesrvConfig.setConfigStorePath(file):将配置文件的路径保存到配置保存字段 -

if (null == namesrvConfig.getRocketmqHome()):检查 ROCKETMQ_HOME 配置是否是空,是空就报错 -

lc = (LoggerContext) LoggerFactory.getILoggerFactory():创建日志对象 -

controller = new NamesrvController(namesrvConfig, nettyServerConfig):创建 Namesrv 控制器

NamesrvStartup#start:启动 Namesrv 控制器

-

boolean initResult = controller.initialize():初始化方法 -

Runtime.getRuntime().addShutdownHook(new ShutdownHookThread()):JVM HOOK 平滑关闭的逻辑, 当 JVM 被关闭时,主动调用 controller.shutdown() 方法,让服务器平滑关机 -

controller.start():启动服务器

源码解析参考视频:https://space.bilibili.com/457326371

控制器类

NamesrvController 用来初始化和启动 Namesrv 服务器

-

成员变量:

private final ScheduledExecutorService scheduledExecutorService; // 调度线程池,用来执行定时任务 private final RouteInfoManager routeInfoManager; // 管理【路由信息】的对象 private RemotingServer remotingServer; // 【网络层】封装对象 private BrokerHousekeepingService brokerHousekeepingService; // 用于监听 channel 状态private ExecutorService remotingExecutor:业务线程池,netty 线程解析报文成 RemotingCommand 对象,然后将该对象交给业务线程池再继续处理 -

初始化:

public boolean initialize() { // 加载本地kv配置(我还不明白 kv 配置是啥) this.kvConfigManager.load(); // 创建网络服务器对象,【将 netty 的配置和监听器传入】 // 监听器监听 channel 状态的改变,会向事件队列发起事件,最后交由 service 处理 this.remotingServer = new NettyRemotingServer(this.nettyServerConfig, this.brokerHousekeepingService); // 【创建业务线程池,默认线程数 8】 this.remotingExecutor = Executors.newFixedThreadPool(nettyServerConfig.getServerWorkerThreads().); // 注册协议处理器(缺省协议处理器),【处理器是 DefaultRequestProcessor】,线程使用的是刚创建的业务的线程池 this.registerProcessor(); // 定时任务1:每 10 秒钟检查 broker 存活状态,将 IDLE 状态的 broker 移除【扫描机制,心跳检测】 this.scheduledExecutorService.scheduleAtFixedRate(new Runnable() { @Override public void run() { // 扫描 brokerLiveTable 表,将两小时没有活动的 broker 关闭, // 通过 next.getKey() 获取 broker 的地址,然后【关闭服务器与broker物理节点的 channel】 NamesrvController.this.routeInfoManager.scanNotActiveBroker(); } }, 5, 10, TimeUnit.SECONDS); // 定时任务2:每 10 分钟打印一遍 kv 配置。 this.scheduledExecutorService.scheduleAtFixedRate(new Runnable() { @Override public void run() { NamesrvController.this.kvConfigManager.printAllPeriodically(); } }, 1, 10, TimeUnit.MINUTES); return true; } -

启动方法:

public void start() throws Exception { // 服务器网络层启动。 this.remotingServer.start(); if (this.fileWatchService != null) { this.fileWatchService.start(); } }

网络通信

通信原理

RocketMQ 的 RPC 通信采用 Netty 组件作为底层通信库,同样也遵循了 Reactor 多线程模型,NettyRemotingServer 类负责框架的通信服务,同时又在这之上做了一些扩展和优化

RocketMQ 基于 NettyRemotingServer 的 Reactor 多线程模型:

-

一个 Reactor 主线程(eventLoopGroupBoss)负责监听 TCP 网络连接请求,建立好连接创建 SocketChannel(RocketMQ 会自动根据 OS 的类型选择 NIO 和 Epoll,也可以通过参数配置),并注册到 Selector 上,然后监听真正的网络数据

-

拿到网络数据交给 Worker 线程池(eventLoopGroupSelector,默认设置为 3),在真正执行业务逻辑之前需要进行 SSL 验证、编解码、空闲检查、网络连接管理,这些工作交给 defaultEventExecutorGroup(默认设置为 8)去做

-

处理业务操作放在业务线程池中执行,根据 RomotingCommand 的业务请求码 code 去 processorTable 这个本地缓存变量中找到对应的 processor,封装成 task 任务提交给对应的 processor 处理线程池来执行(sendMessageExecutor,以发送消息为例)

-

从入口到业务逻辑的几个步骤中线程池一直再增加,这跟每一步逻辑复杂性相关,越复杂,需要的并发通道越宽

| 线程数 | 线程名 | 线程具体说明 |

|---|---|---|

| 1 | NettyBoss_%d | Reactor 主线程 |

| N | NettyServerEPOLLSelector_%d_%d | Reactor 线程池 |

| M1 | NettyServerCodecThread_%d | Worker 线程池 |

| M2 | RemotingExecutorThread_%d | 业务 processor 处理线程池 |

RocketMQ 的异步通信流程:

==todo:后期对 Netty 有了更深的认知后会进行扩充,现在暂时 copy 官方文档==

官方文档:https://github.com/apache/rocketmq/blob/master/docs/cn/design.md#2-通信机制

成员属性

NettyRemotingServer 类成员变量:

-

服务器相关属性:

private final ServerBootstrap serverBootstrap; // netty 服务端启动对象 private final EventLoopGroup eventLoopGroupSelector; // netty worker 组线程池,【默认 3 个线程】 private final EventLoopGroup eventLoopGroupBoss; // netty boss 组线程池,【一般是 1 个线程】 private final NettyServerConfig nettyServerConfig; // netty 服务端网络配置 private int port = 0; // 服务器绑定的端口 -

公共线程池:注册处理器时如果未指定线程池,则业务处理使用公共线程池,线程数量默认是 4

private final ExecutorService publicExecutor; -

事件监听器:Nameserver 使用 BrokerHouseKeepingService,Broker 使用 ClientHouseKeepingService

private final ChannelEventListener channelEventListener; -

事件处理线程池:默认是 8

private DefaultEventExecutorGroup defaultEventExecutorGroup; -

定时器:执行循环任务,并且将定时器线程设置为守护线程

private final Timer timer = new Timer("ServerHouseKeepingService", true); -

处理器:多个 Channel 共享的处理器 Handler,多个通道使用同一个对象

-

Netty 配置对象:

public class NettyServerConfig implements Cloneable { // 服务端启动时监听的端口号 private int listenPort = 8888; // 【业务线程池】 线程数量 private int serverWorkerThreads = 8; // 根据该值创建 remotingServer 内部的一个 publicExecutor private int serverCallbackExecutorThreads = 0; // netty 【worker】线程数 private int serverSelectorThreads = 3; // 【单向访问】时的并发限制 private int serverOnewaySemaphoreValue = 256; // 【异步访问】时的并发限制 private int serverAsyncSemaphoreValue = 64; // channel 最大的空闲存活时间 默认是 2min private int serverChannelMaxIdleTimeSeconds = 120; // 发送缓冲区大小 65535 private int serverSocketSndBufSize = NettySystemConfig.socketSndbufSize; // 接收缓冲区大小 65535 private int serverSocketRcvBufSize = NettySystemConfig.socketRcvbufSize; // 是否启用 netty 内存池 默认开启 private boolean serverPooledByteBufAllocatorEnable = true; // 默认 linux 会启用 【epoll】 private boolean useEpollNativeSelector = false; }

构造方法:

-

无监听器构造:

public NettyRemotingServer(final NettyServerConfig nettyServerConfig) { this(nettyServerConfig, null); } -

有参构造方法:

public NettyRemotingServer(final NettyServerConfig nettyServerConfig, final ChannelEventListener channelEventListener) { // 服务器对客户端主动发起请求时并发限制。【单向请求和异步请求】的并发限制 super(nettyServerConfig.getServerOnewaySemaphoreValue(), nettyServerConfig.getServerAsyncSemaphoreValue()); // Netty 的启动器,负责组装 netty 组件 this.serverBootstrap = new ServerBootstrap(); // 成员变量的赋值 this.nettyServerConfig = nettyServerConfig; this.channelEventListener = channelEventListener; // 公共线程池的线程数量,默认给的0,这里最终修改为4. int publicThreadNums = nettyServerConfig.getServerCallbackExecutorThreads(); if (publicThreadNums <= 0) { publicThreadNums = 4; } // 创建公共线程池,指定线程工厂,设置线程名称前缀:NettyServerPublicExecutor_[数字] this.publicExecutor = Executors.newFixedThreadPool(publicThreadNums, new ThreadFactory(){.}); // 创建两个 netty 的线程组,一个是boss组,一个是worker组,【linux 系统默认启用 epoll】 if (useEpoll()) {...} else {...} // SSL 相关 loadSslContext(); }

启动方法

核心方法的解析:

-

start():启动方法,创建 BootStrap,并添加 NettyServerHandler 处理器

public void start() { // Channel Pipeline 内的 handler 使用的线程资源,【线程分配给 handler 处理事件】 this.defaultEventExecutorGroup = new DefaultEventExecutorGroup(...); // 创建通用共享的处理器 handler,【非常重要的 NettyServerHandler】 prepareSharableHandlers(); ServerBootstrap childHandler = // 配置工作组 boss(数量1) 和 worker(数量3) 组 this.serverBootstrap.group(this.eventLoopGroupBoss, this.eventLoopGroupSelector) // 设置服务端 ServerSocketChannel 类型, Linux 用 epoll .channel(useEpoll() ? EpollServerSocketChannel.class : NioServerSocketChannel.class) // 设置服务端 channel 选项 .option(ChannelOption.SO_BACKLOG, 1024) // 客户端 channel 选项 .childOption(ChannelOption.TCP_NODELAY, true) // 设置服务器端口 .localAddress(new InetSocketAddress(this.nettyServerConfig.getListenPort())) // 向 channel pipeline 添加了很多 handler,【包括 NettyServerHandler】 .childHandler(new ChannelInitializer<SocketChannel>() {}); // 客户端开启 内存池,使用的内存池是 PooledByteBufAllocator.DEFAULT if (nettyServerConfig.isServerPooledByteBufAllocatorEnable()) { childHandler.childOption(ChannelOption.ALLOCATOR, PooledByteBufAllocator.DEFAULT); } try { // 同步等待建立连接,并绑定端口。 ChannelFuture sync = this.serverBootstrap.bind().sync(); InetSocketAddress addr = (InetSocketAddress) sync.channel().localAddress(); // 将服务器成功绑定的端口号赋值给字段 port。 this.port = addr.getPort(); } catch (InterruptedException e1) {} // housekeepingService 不为空,则创建【网络异常事件处理器】 if (this.channelEventListener != null) { // 线程一直轮询 nettyEvent 状态,根据 CONNECT,CLOSE,IDLE,EXCEPTION 四种事件类型 // CONNECT 不做操作,其余都是回调 onChannelDestroy 【关闭服务器与 Broker 物理节点的 Channel】 this.nettyEventExecutor.start(); } // 提交定时任务,每一秒 执行一次。扫描 responseTable 表,将过期的数据移除 this.timer.scheduleAtFixedRate(new TimerTask() { @Override public void run() { NettyRemotingServer.this.scanResponseTable(); } }, 1000 * 3, 1000); } -

registerProcessor():注册业务处理器

public void registerProcessor(int requestCode, NettyRequestProcessor processor, ExecutorService executor) { ExecutorService executorThis = executor; if (null == executor) { // 未指定线程池资源,将公共线程池赋值 executorThis = this.publicExecutor; } // pair 对象,第一个参数代表的是处理器, 第二个参数是线程池,默认是公共的线程池 Pair<NettyRequestProcessor, ExecutorService> pair = new Pair<NettyRequestProcessor, ExecutorService>(processor, executorThis); // key 是请求码,value 是 Pair 对象 this.processorTable.put(requestCode, pair); } -

getProcessorPair():根据请求码获取对应的处理器和线程池资源

public Pair<NettyRequestProcessor, ExecutorService> getProcessorPair(int requestCode) { return processorTable.get(requestCode); }

请求方法

在 RocketMQ 消息队列中支持通信的方式主要有同步(sync)、异步(async)、单向(oneway)三种,其中单向通信模式相对简单,一般用在发送心跳包场景下,无需关注其 Response

服务器主动向客户端发起请求时,使用三种方法

-

invokeSync(): 同步调用,服务器需要阻塞等待调用的返回结果

int opaque = request.getOpaque():获取请求 ID(与请求码不同)responseFuture = new ResponseFuture(...):创建响应对象,没有回调函数和 Oncethis.responseTable.put(opaque, responseFuture):加入到响应映射表中,key 为请求 IDSocketAddress addr = channel.remoteAddress():获取客户端的地址信息channel.writeAndFlush(request).addListener(...):将业务 Command 信息写入通道,业务线程将数据交给 Netty ,Netty 的 IO 线程接管写刷数据的操作,监听器由 IO 线程在写刷后回调if (f.isSuccess()):写入成功会将响应对象设置为成功状态直接 return,写入失败设置为失败状态responseTable.remove(opaque):将当前请求的 responseFuture 从映射表移除responseFuture.setCause(f.cause()):设置错误的信息responseFuture.putResponse(null):响应 Command 设置为 null

responseCommand = responseFuture.waitResponse(timeoutMillis):当前线程设置超时时间挂起,同步等待响应if (null == responseCommand):超时或者出现异常,直接报错return responseCommand:返回响应 Command 信息

-

invokeAsync():异步调用,有回调对象,无返回值

boolean acquired = this.semaphoreAsync.tryAcquire(timeoutMillis, TimeUnit.MILLISECONDS):获取信号量的许可证,信号量用来限制异步请求的数量if (acquired):许可证获取失败说明并发较高,会抛出异常once = new SemaphoreReleaseOnlyOnce(this.semaphoreAsync):Once 对象封装了释放信号量的操作costTime = System.currentTimeMillis() - beginStartTime:计算一下耗费的时间,超时不再发起请求responseFuture = new ResponseFuture():创建响应对象,包装了回调函数和 Once 对象this.responseTable.put(opaque, responseFuture):加入到响应映射表中,key 为请求 IDchannel.writeAndFlush(request).addListener(...):写刷数据if (f.isSuccess()):写刷成功,设置 responseFuture 发生状态为 truerequestFail(opaque):写入失败,使用 publicExecutor 公共线程池异步执行回调对象的函数responseFuture.release():出现异常会释放信号量

-

invokeOneway():单向调用,不关注响应结果

request.markOnewayRPC():设置单向标记,对端检查标记可知该请是单向请求boolean acquired = this.semaphoreOneway.tryAcquire(timeoutMillis, TimeUnit.MILLISECONDS):获取信号量的许可证,信号量用来限制单向请求的数量

处理器类

协议设计

在 Client 和 Server 之间完成一次消息发送时,需要对发送的消息进行一个协议约定,所以自定义 RocketMQ 的消息协议。在 RocketMQ 中,为了高效地在网络中传输消息和对收到的消息读取,就需要对消息进行编解码,RemotingCommand 这个类在消息传输过程中对所有数据内容的封装,不但包含了所有的数据结构,还包含了编码解码操作

| Header字段 | 类型 | Request 说明 | Response 说明 |

|---|---|---|---|

| code | int | 请求操作码,应答方根据不同的请求码进行不同的处理 | 应答响应码,0 表示成功,非 0 则表示各种错误 |

| language | LanguageCode | 请求方实现的语言 | 应答方实现的语言 |

| version | int | 请求方程序的版本 | 应答方程序的版本 |

| opaque | int | 相当于 requestId,在同一个连接上的不同请求标识码,与响应消息中的相对应 | 应答不做修改直接返回 |

| flag | int | 区分是普通 RPC 还是 onewayRPC 的标志 | 区分是普通 RPC 还是 onewayRPC的标志 |

| remark | String | 传输自定义文本信息 | 传输自定义文本信息 |

| extFields | HashMap<String, String> | 请求自定义扩展信息 | 响应自定义扩展信息 |

传输内容主要可以分为以下四部分:

-

消息长度:总长度,四个字节存储,占用一个 int 类型

-

序列化类型&消息头长度:同样占用一个 int 类型,第一个字节表示序列化类型,后面三个字节表示消息头长度

-

消息头数据:经过序列化后的消息头数据

-

消息主体数据:消息主体的二进制字节数据内容

官方文档:https://github.com/apache/rocketmq/blob/master/docs/cn/design.md

处理方法

NettyServerHandler 类用来处理 Channel 上的事件,在 NettyRemotingServer 启动时注册到 Netty 中,可以处理 RemotingCommand 相关的数据,针对某一种类型的请求处理

class NettyServerHandler extends SimpleChannelInboundHandler<RemotingCommand> {

@Override

protected void channelRead0(ChannelHandlerContext ctx, RemotingCommand msg) throws Exception {

// 服务器处理接受到的请求信息

processMessageReceived(ctx, msg);

}

}

public void processMessageReceived(ChannelHandlerContext ctx, RemotingCommand msg) throws Exception {

final RemotingCommand cmd = msg;

if (cmd != null) {

// 根据请求的类型进行处理

switch (cmd.getType()) {

case REQUEST_COMMAND:// 客户端发起的请求,走这里

processRequestCommand(ctx, cmd);

break;

case RESPONSE_COMMAND:// 客户端响应的数据,走这里【当前类本身是服务器类也是客户端类】

processResponseCommand(ctx, cmd);

break;

default:

break;

}

}

}

NettyRemotingAbstract#processRequestCommand:处理请求的数据

-

matched = this.processorTable.get(cmd.getCode()):根据业务请求码获取 Pair 对象,包含处理器和线程池资源 -

pair = null == matched ? this.defaultRequestProcessor : matched:未找到处理器则使用缺省处理器 -

int opaque = cmd.getOpaque():获取请求 ID -

Runnable run = new Runnable():创建任务对象,任务在提交到线程池后开始执行-

doBeforeRpcHooks():RPC HOOK 前置处理 -

callback = new RemotingResponseCallback():封装响应客户端的逻辑doAfterRpcHooks():RPC HOOK 后置处理if (!cmd.isOnewayRPC()):条件成立说明不是单向请求,需要结果response.setOpaque(opaque):将请求 ID 设置到 responseresponse.markResponseType():设置当前请求是响应ctx.writeAndFlush(response): 将响应数据交给 Netty IO 线程,完成数据写和刷

-

if (pair.getObject1() instanceof AsyncNettyRequestProcessor):Nameserver 默认使用 DefaultRequestProcessor 处理器,是一个 AsyncNettyRequestProcessor 子类 -

processor = (AsyncNettyRequestProcessor)pair.getObject1():获取处理器 -

processor.asyncProcessRequest(ctx, cmd, callback):异步调用,首先 processRequest,然后 callback 响应客户端DefaultRequestProcessor.processRequest:根据业务码处理请求,执行对应的操作ClientRemotingProcessor.processRequest:处理事务回查消息,或者回执消息,需要消费者回执一条消息给生产者

-

-

requestTask = new RequestTask(run, ctx.channel(), cmd):将任务对象、通道、请求封装成 RequestTask 对象 -

pair.getObject2().submit(requestTask):获取处理器对应的线程池,将 task 提交,从 IO 线程切换到业务线程

NettyRemotingAbstract#processResponseCommand:处理响应的数据

int opaque = cmd.getOpaque():获取请求 IDresponseFuture = responseTable.get(opaque):从响应映射表中获取对应的对象responseFuture.setResponseCommand(cmd):设置响应的 Command 对象responseTable.remove(opaque):从映射表中移除对象,代表处理完成if (responseFuture.getInvokeCallback() != null):包含回调对象,异步执行回调对象responseFuture.putResponse(cmd):不包含回调对象,同步调用时,唤醒等待的业务线程

流程:客户端 invokeSync → 服务器的 processRequestCommand → 客户端的 processResponseCommand → 结束

路由信息

信息管理

RouteInfoManager 类负责管理路由信息,NamesrvController 的构造方法中创建该类的实例对象,管理服务端的路由数据

public class RouteInfoManager {

// Broker 两个小时不活跃,视为离线,被定时任务删除

private final static long BROKER_CHANNEL_EXPIRED_TIME = 1000 * 60 * 2;

// 读写锁,保证线程安全

private final ReadWriteLock lock = new ReentrantReadWriteLock();

// 主题队列数据,一个主题对应多个队列

private final HashMap<String/* topic */, List<QueueData>> topicQueueTable;

// Broker 数据列表

private final HashMap<String/* brokerName */, BrokerData> brokerAddrTable;

// 集群

private final HashMap<String/* clusterName */, Set<String/* brokerName */>> clusterAddrTable;

// Broker 存活信息

private final HashMap<String/* brokerAddr */, BrokerLiveInfo> brokerLiveTable;

// 服务过滤

private final HashMap<String/* brokerAddr */, List<String>/* Filter Server */> filterServerTable;

}

路由注册

DefaultRequestProcessor REGISTER_BROKER 方法解析:

public RemotingCommand registerBroker(ChannelHandlerContext ctx, RemotingCommand request) {

// 创建响应请求的对象,设置为响应类型,【先设置响应的状态码时系统错误码】

// 反射创建 RegisterBrokerResponseHeader 对象设置到 response.customHeader 属性中

final RemotingCommand response = RemotingCommand.createResponseCommand(RegisterBrokerResponseHeader.class);

// 获取出反射创建的 RegisterBrokerResponseHeader 用户自定义header对象。

final RegisterBrokerResponseHeader responseHeader = (RegisterBrokerResponseHeader) response.readCustomHeader();

// 反射创建 RegisterBrokerRequestHeader 对象,并且将 request.extFields 中的数据写入到该对象中

final RegisterBrokerRequestHeader requestHeader = request.decodeCommandCustomHeader(RegisterBrokerRequestHeader.class);

// CRC 校验,计算请求中的 CRC 值和请求头中包含的是否一致

if (!checksum(ctx, request, requestHeader)) {

response.setCode(ResponseCode.SYSTEM_ERROR);

response.setRemark("crc32 not match");

return response;

}

TopicConfigSerializeWrapper topicConfigWrapper;

if (request.getBody() != null) {

// 【解析请求体 body】,解码出来的数据就是当前机器的主题信息

topicConfigWrapper = TopicConfigSerializeWrapper.decode(request.getBody(), TopicConfigSerializeWrapper.class);

} else {

topicConfigWrapper = new TopicConfigSerializeWrapper();

topicConfigWrapper.getDataVersion().setCounter(new AtomicLong(0));

topicConfigWrapper.getDataVersion().setTimestamp(0);

}

// 注册方法

// 参数1 集群、参数2:节点ip地址、参数3:brokerName、参数4:brokerId 注意brokerId=0的节点为主节点

// 参数5:ha节点ip地址、参数6当前节点主题信息、参数7:过滤服务器列表、参数8:当前服务器和客户端通信的channel

RegisterBrokerResult result = this.namesrvController.getRouteInfoManager().registerBroker(..);

// 将结果信息 写到 responseHeader 中

responseHeader.setHaServerAddr(result.getHaServerAddr());

responseHeader.setMasterAddr(result.getMasterAddr());

// 获取 kv配置,写入 response body 中,【kv 配置是顺序消息相关的】

byte[] jsonValue = this.namesrvController.getKvConfigManager().getKVListByNamespace(NamesrvUtil.NAMESPACE_ORDER_TOPIC);

response.setBody(jsonValue);

// code 设置为 SUCCESS

response.setCode(ResponseCode.SUCCESS);

response.setRemark(null);

// 返回 response ,【返回的 response 由 callback 对象处理】

return response;

}

RouteInfoManager#registerBroker:注册 Broker 的信息

-

RegisterBrokerResult result = new RegisterBrokerResult():返回结果的封装对象 -

this.lock.writeLock().lockInterruptibly():加写锁后同步执行 -

brokerNames = this.clusterAddrTable.get(clusterName):获取当前集群上的 Broker 名称列表,是空就新建列表 -

brokerNames.add(brokerName):将当前 Broker 名字加入到集群列表 -

brokerData = this.brokerAddrTable.get(brokerName):获取当前 Broker 的 brokerData,是空就新建放入映射表 -

brokerAddrsMap = brokerData.getBrokerAddrs():获取当前 Broker 的物理节点 map 表,进行遍历,如果物理节点角色发生变化(slave → master),先将旧数据从物理节点 map 中移除,然后重写放入,保证节点的唯一性 -

if (null != topicConfigWrapper && MixAll.MASTER_ID == brokerId):Broker 上的 Topic 不为 null,并且当前物理节点是 Broker 上的 master 节点tcTable = topicConfigWrapper.getTopicConfigTable():获取当前 Broker 信息中的主题映射表if (tcTable != null):映射表不空就加入或者更新到 Namesrv 内 -

prevBrokerLiveInfo = this.brokerLiveTable.put(brokerAddr):添加当前节点的 BrokerLiveInfo ,返回上一次心跳时当前 Broker 节点的存活对象数据。NamesrvController 中的定时任务会扫描映射表 brokerLiveTableBrokerLiveInfo prevBrokerLiveInfo = this.brokerLiveTable.put(brokerAddr, new BrokerLiveInfo( System.currentTimeMillis(),topicConfigWrapper.getDataVersion(), channel,haServerAddr)); -

if (MixAll.MASTER_ID != brokerId):当前 Broker 不是 master 节点,获取主节点的信息设置到结果对象 -

this.lock.writeLock().unlock():释放写锁

Broker

MappedFile

成员属性

MappedFile 类是最基础的存储类,继承自 ReferenceResource 类,用来保证线程安全

MappedFile 类成员变量:

-

内存相关:

public static final int OS_PAGE_SIZE = 1024 * 4;// 内存页大小:默认是 4k private AtomicLong TOTAL_MAPPED_VIRTUAL_MEMORY; // 当前进程下所有的 mappedFile 占用的总虚拟内存大小 private AtomicInteger TOTAL_MAPPED_FILES; // 当前进程下所有的 mappedFile 个数 -

数据位点:

protected final AtomicInteger wrotePosition; // 当前 mappedFile 的数据写入点 protected final AtomicInteger committedPosition;// 当前 mappedFile 的数据提交点 private final AtomicInteger flushedPosition; // 数据落盘位点,在这之前的数据是持久化的安全数据 // flushedPosition-wrotePosition 之间的数据属于脏页 -

文件相关:CL 是 CommitLog,CQ 是 ConsumeQueue

private String fileName; // 文件名称,CL和CQ文件名是【第一条消息的物理偏移量】,索引文件是【年月日时分秒】 private long fileFromOffset;// 文件名转long,代表该对象的【起始偏移量】 private File file; // 文件对象MF 中以物理偏移量作为文件名,可以更好的寻址和进行判断

-

内存映射:

protected FileChannel fileChannel; // 文件通道 private MappedByteBuffer mappedByteBuffer; // 内存映射缓冲区,访问虚拟内存

ReferenceResource 类成员变量:

-

引用数量:当

refCount <= 0时,表示该资源可以释放了,没有任何其他程序依赖它了,用原子类保证线程安全protected final AtomicLong refCount = new AtomicLong(1); // 初始值为 1 -

存活状态:表示资源的存活状态

protected volatile boolean available = true; -

是否清理:默认值 false,当执行完子类对象的 cleanup() 清理方法后,该值置为 true ,表示资源已经全部释放

protected volatile boolean cleanupOver = false; -

第一次关闭资源的时间:用来记录超时时间

private volatile long firstShutdownTimestamp = 0;

成员方法

MappedFile 类核心方法:

-

appendMessage():提供上层向内存映射中追加消息的方法,消息如何追加由 AppendMessageCallback 控制

// 参数一:消息 参数二:追加消息回调 public AppendMessageResult appendMessage(MessageExtBrokerInner msg, AppendMessageCallback cb)// 将字节数组写入到文件通道 public boolean appendMessage(final byte[] data) -

flush():刷盘接口,参数 flushLeastPages 代表刷盘的最小页数 ,等于 0 时属于强制刷盘;> 0 时需要脏页(计算方法在数据位点)达到该值才进行物理刷盘;文件写满时强制刷盘

public int flush(final int flushLeastPages) -

selectMappedBuffer():该方法以 pos 为开始位点 ,到有效数据为止,创建一个切片 ByteBuffer 作为数据副本,供业务访问数据

public SelectMappedBufferResult selectMappedBuffer(int pos) -

destroy():销毁映射文件对象,并删除关联的系统文件,参数是强制关闭资源的时间

public boolean destroy(final long intervalForcibly) -

cleanup():释放堆外内存,更新总虚拟内存和总内存映射文件数

public boolean cleanup(final long currentRef) -

warmMappedFile():内存预热,当要新建的 MappedFile 对象大于 1g 时执行该方法。mappedByteBuffer 已经通过mmap映射,此时操作系统中只是记录了该文件和该 Buffer 的映射关系,而并没有映射到物理内存中,对该 MappedFile 的每个 Page Cache 进行写入一个字节分配内存,将映射文件全部加载到内存

public void warmMappedFile(FlushDiskType type, int pages) -

mlock():锁住指定的内存区域避免被操作系统调到 swap 空间,减少了缺页异常的产生

public void mlock()swap space 是磁盘上的一块区域,可以是一个分区或者一个文件或者是组合。当系统物理内存不足时,Linux 会将内存中不常访问的数据保存到 swap 区域上,这样系统就可以有更多的物理内存为各个进程服务,而当系统需要访问 swap 上存储的内容时,需要通过缺页中断将 swap 上的数据加载到内存中

ReferenceResource 类核心方法:

-

hold():增加引用记数 refCount,方法加锁

public synchronized boolean hold() -

shutdown():关闭资源,参数代表强制关闭资源的时间间隔

// 系统当前时间 - firstShutdownTimestamp 时间 > intervalForcibly 进行【强制关闭】 public void shutdown(final long intervalForcibly) -

release():引用计数减 1,当 refCount 为 0 时,调用子类的 cleanup 方法

public void release()

MapQueue

成员属性

MappedFileQueue 用来管理 MappedFile 文件

成员变量:

-

管理目录:CommitLog 是

../store/commitlog, ConsumeQueue 是../store/xxx_topic/0private final String storePath; -

文件属性:

private final int mappedFileSize; // 目录下每个文件大小,CL文件默认 1g,CQ文件 默认 600w字节 private final CopyOnWriteArrayList<MappedFile> mappedFiles; //目录下的每个 mappedFile 都加入该集合 -

数据位点:

private long flushedWhere = 0; // 目录的刷盘位点,值为 mf.fileName + mf.wrotePosition private long committedWhere = 0; // 目录的提交位点 -

消息存储:

private volatile long storeTimestamp = 0; // 当前目录下最后一条 msg 的存储时间 -

创建服务:新建 MappedFile 实例,继承自 ServiceThread 是一个任务对象,run 方法用来创建实例

private final AllocateMappedFileService allocateMappedFileService;

成员方法

核心方法:

-

load():Broker 启动时,加载本地磁盘数据,该方法读取 storePath 目录下的文件,创建 MappedFile 对象放入集合内

public boolean load() -

getLastMappedFile():获取当前正在顺序写入的 MappedFile 对象,如果最后一个 MappedFile 写满了,或者不存在 MappedFile 对象,则创建新的 MappedFile

// 参数一:文件起始偏移量;参数二:当list为空时,是否新建 MappedFile public MappedFile getLastMappedFile(final long startOffset, boolean needCreate) -

flush():根据 flushedWhere 属性查找合适的 MappedFile,调用该 MappedFile 的落盘方法,并更新全局的 flushedWhere

//参数:0 表示强制刷新, > 0 脏页数据必须达到 flushLeastPages 才刷新 public boolean flush(final int flushLeastPages) -

findMappedFileByOffset():根据偏移量查询对象

public MappedFile findMappedFileByOffset(final long offset, final boolean returnFirstOnNotFound) -

deleteExpiredFileByTime():CL 删除过期文件,根据文件的保留时长决定是否删除

// 参数一:过期时间; 参数二:删除两个文件之间的时间间隔; 参数三:mf.destory传递的参数; 参数四:true 强制删除 public int deleteExpiredFileByTime(final long expiredTime,final int deleteFilesInterval, final long intervalForcibly, final boolean cleanImmediately) -

deleteExpiredFileByOffset():CQ 删除过期文件,遍历每个 MF 文件,获取当前文件最后一个数据单元的物理偏移量,小于 offset 说明当前 MF 文件内都是过期数据

// 参数一:consumeLog 目录下最小物理偏移量,就是第一条消息的 offset; // 参数二:ConsumerQueue 文件内每个数据单元固定大小 public int deleteExpiredFileByOffset(long offset, int unitSize)

CommitLog

成员属性

成员变量:

-

魔数:

public final static int MESSAGE_MAGIC_CODE = -626843481; // 消息的第一个字段是大小,第二个字段就是魔数 protected final static int BLANK_MAGIC_CODE = -875286124; // 文件尾消息的魔法值 -

MappedFileQueue:用于管理

../store/commitlog目录下的文件protected final MappedFileQueue mappedFileQueue; -

存储服务:

protected final DefaultMessageStore defaultMessageStore; // 存储模块对象,上层服务 private final FlushCommitLogService flushCommitLogService; // 刷盘服务,默认实现是异步刷盘 -

回调器:控制消息的哪些字段添加到 MappedFile

private final AppendMessageCallback appendMessageCallback; -

队列偏移量字典表:key 是主题队列 id,value 是偏移量

protected HashMap<String, Long> topicQueueTable = new HashMap<String, Long>(1024); -

锁相关:

private volatile long beginTimeInLock = 0; // 写数据时加锁的开始时间 protected final PutMessageLock putMessageLock; // 写锁,两个实现类:自旋锁和重入锁因为发送消息是需要持久化的,在 Broker 端持久化时会获取该锁,保证发送的消息的线程安全

构造方法:

-

有参构造:

public CommitLog(final DefaultMessageStore defaultMessageStore) { // 创建 MappedFileQueue 对象 // 参数1:../store/commitlog; 参数2:【1g】; 参数3:allocateMappedFileService this.mappedFileQueue = new MappedFileQueue(...); // 默认 异步刷盘,创建这个对象 this.flushCommitLogService = new FlushRealTimeService(); // 控制消息哪些字段追加到 mappedFile,【消息最大是 4M】 this.appendMessageCallback = new DefaultAppendMessageCallback(...); // 默认使用自旋锁 this.putMessageLock = ...; }

成员方法

CommitLog 类核心方法:

-

start():会启动刷盘服务

public void start() -

shutdown():关闭刷盘服务

public void shutdown() -

load():加载 CommitLog 目录下的文件

public boolean load() -

getMessage():根据 offset 查询单条信息,返回的结果对象内部封装了一个 ByteBuffer,该 Buffer 表示

[offset, offset + size]区间的 MappedFile 的数据public SelectMappedBufferResult getMessage(final long offset, final int size) -

deleteExpiredFile():删除过期文件,方法由 DefaultMessageStore 的定时任务调用

public int deleteExpiredFile() -

asyncPutMessage():存储消息

public CompletableFuture<PutMessageResult> asyncPutMessage(final MessageExtBrokerInner msg)msg.setStoreTimestamp(System.currentTimeMillis()):设置存储时间,后面获取到写锁后这个事件会重写msg.setBodyCRC(UtilAll.crc32(msg.getBody())):获取消息的 CRC 值topic、queueId:获取主题和队列 IDif (msg.getDelayTimeLevel() > 0):获取消息的延迟级别,这里是延迟消息实现的关键topic = TopicValidator.RMQ_SYS_SCHEDULE_TOPIC:修改消息的主题为SCHEDULE_TOPIC_XXXXqueueId = ScheduleMessageService.delayLevel2QueueId():队列 ID 为延迟级别 -1MessageAccessor.putProperty:将原来的消息主题和 ID 存入消息的属性REAL_TOPIC中mappedFile = this.mappedFileQueue.getLastMappedFile():获取当前顺序写的 MappedFile 对象putMessageLock.lock():获取写锁msg.setStoreTimestamp(beginLockTimestamp):设置消息的存储时间为获取锁的时间if (null == mappedFile || mappedFile.isFull()):文件写满了创建新的 MF 对象result = mappedFile.appendMessage(msg, this.appendMessageCallback):消息追加,核心逻辑在回调器类putMessageLock.unlock():释放写锁this.defaultMessageStore.unlockMappedFile(..):将 MappedByteBuffer 从 lock 切换为 unlock 状态putMessageResult = new PutMessageResult(PutMessageStatus.PUT_OK, result):结果封装flushResultFuture = submitFlushRequest(result, msg):唤醒刷盘线程replicaResultFuture = submitReplicaRequest(result, msg):HA 消息同步

-

recoverNormally():正常关机时的恢复方法,存储模块启动时先恢复所有的 ConsumeQueue 数据,再恢复 CommitLog 数据

// 参数表示恢复阶段 ConsumeQueue 中已知的最大的消息 offset public void recoverNormally(long maxPhyOffsetOfConsumeQueue)-

int index = mappedFiles.size() - 3:从倒数第三个 file 开始向后恢复 -

dispatchRequest = this.checkMessageAndReturnSize():每次从切片内解析出一条 msg 封装成 DispatchRequest 对象 -

size = dispatchRequest.getMsgSize():获取消息的大小,检查 DispatchRequest 对象的状态情况 1:正常数据,则

mappedFileOffset += size情况 2:文件尾数据,处理下一个文件,mappedFileOffset 置为 0,magic_code 表示文件尾

-

processOffset += mappedFileOffset:计算出正确的数据存储位点,并设置 MappedFileQueue 的目录刷盘位点 -

this.mappedFileQueue.truncateDirtyFiles(processOffset):调整 MFQ 中文件的刷盘位点 -

if (maxPhyOffsetOfConsumeQueue >= processOffset):删除冗余数据,将超过全局位点的 CQ 下的文件删除,将包含全局位点的 CQ 下的文件重新定位

-

-

recoverAbnormally():异常关机时的恢复方法

public void recoverAbnormally(long maxPhyOffsetOfConsumeQueue)int index = mappedFiles.size() - 1:从尾部开始遍历 MFQ,验证 MF 的第一条消息,找到第一个验证通过的文件对象dispatchRequest = this.checkMessageAndReturnSize():每次解析出一条 msg 封装成 DispatchRequest 对象this.defaultMessageStore.doDispatch(dispatchRequest):重建 ConsumerQueue 和 Index,避免上次异常停机导致 CQ 和 Index 与 CommitLog 不对齐- 剩余逻辑与正常关机的恢复方法相似

服务线程

AppendMessageCallback 消息追加服务实现类为 DefaultAppendMessageCallback

-

doAppend():